vLLM源码介绍系列1: API server

vLLM是一款在产业界非常流行的大语言模型推理框架,由Berkeley开发,其通过paged attention、PD分离、continuous batching等技术实现大规模模型的低延迟高吞吐推理

我们一起来看一下vLLM的API server

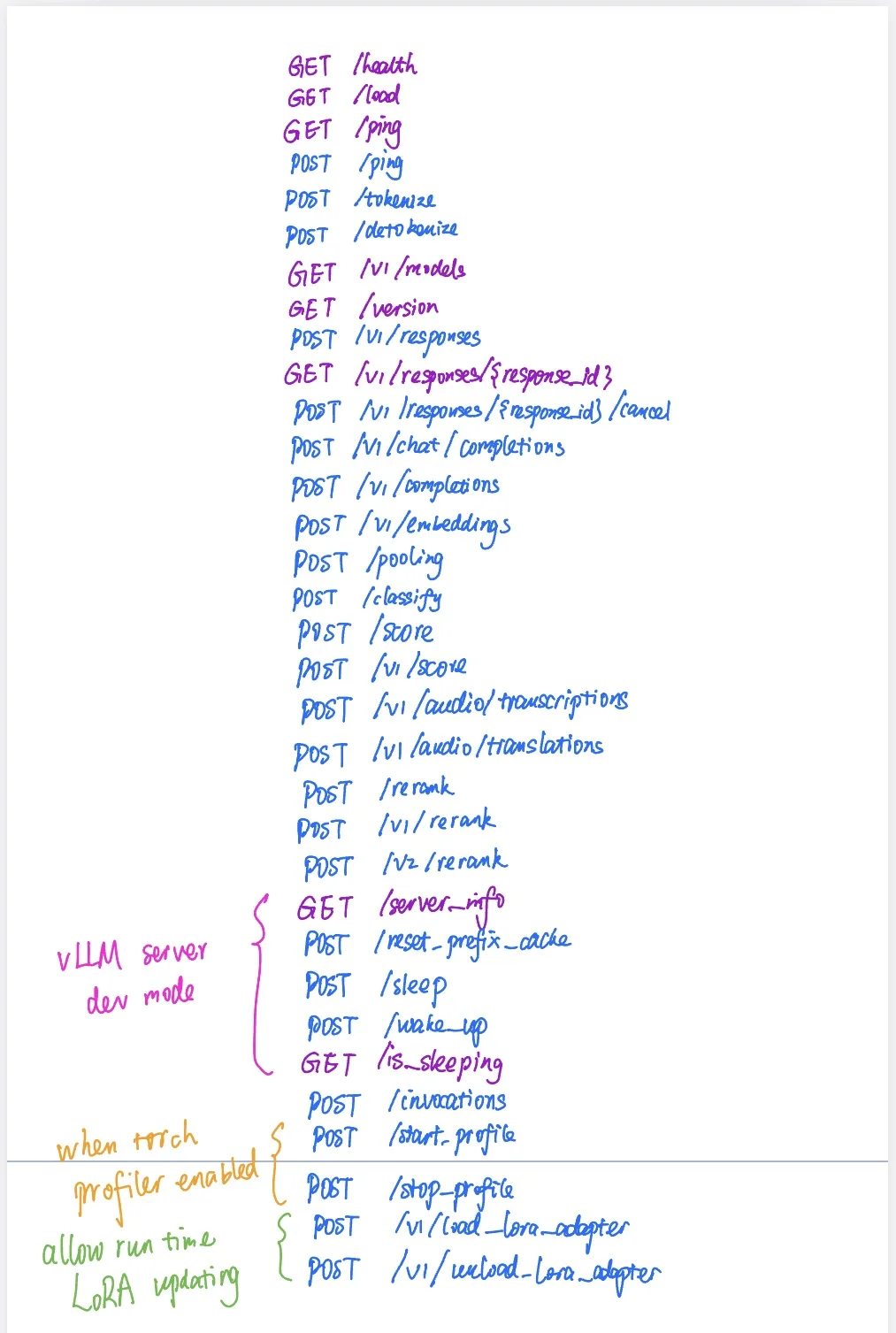

在vllm/entrypoints/openai/api_server.py这个文件里,作者使用FastAPI框架(你看到的@router.get、@router.post这些装饰器的时候,就代表当这个API被调用的时候,会触发这个decorator装饰的函数,进入相应的vLLM底层逻辑)定义了一系列基于OpenAI API的API接口协议,如上图所示,我整理了下来

这些API接口里面相当一部分是和OpenAI API吻合的,但是也有vLLM自己的。有些是只有在特定环境变量生效的情况下才有资格触发

关注我,带你看AI领域的基础知识及最前沿的动态

#大语言模型 #机器学习 #生成式AI #LLM #人工智能 #agent #推理优化 夜雨聆风

夜雨聆风