源码编译GPU版本的FunASR并测试转写性能

说明情况

说明情况funasr-wss-server,不是通过拉取docker中的funasr-wss-server。官方有发布docker可拉取,但是镜像比较大,并且拉取速度慢,之前尝试拉取过几次,后面放弃了,转而使用源码编译方式生成可执行程序来测试。本次测试意在对比测试使用官方的GPU版本的FunASR和使用第三方的TensorRT来推理FunASR提供的模型的资源占用和转写速度,特别是在多卡情况下转写的速度。aishell1_test,总共10.03小时音频,7176条音频。 测试环境

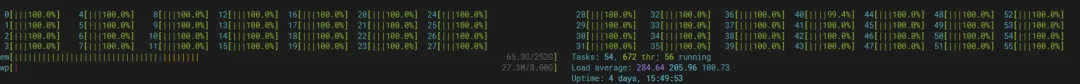

测试环境OS: Ubuntu 22.04Python: 3.8CUDA: 12.8Pytorch:RAM: 256GBGPU: 8张魔改版2080Ti,每张22GB显存CPU: Intel(R) Xeon(R) CPU E5-2680 v4 @ 2.40GHz 56核心

单卡测试

单卡测试--batch-size 32--model-thread-num 16--decoder-thread-num 16--io-thread-num 8

从上面测试结果来看,单张2080Ti魔改版显卡最大支持32并发,当并发数超过32后,RTF值没有明显变化。

同时得出一个结论,显卡利用率低,最多只能利用50%,相比于使用triton_gpu后端使用TensorRT来推理,利用率可以100%。

这里修改一下服务端参数,重新测试一下。

--batch-size 32--model-thread-num 16--decoder-thread-num 22--io-thread-num 8

GPU利用率还是太低了,CPU利用率太高了。修改decoder-thread-num的值并没有提升GPU利用率。 多卡测试

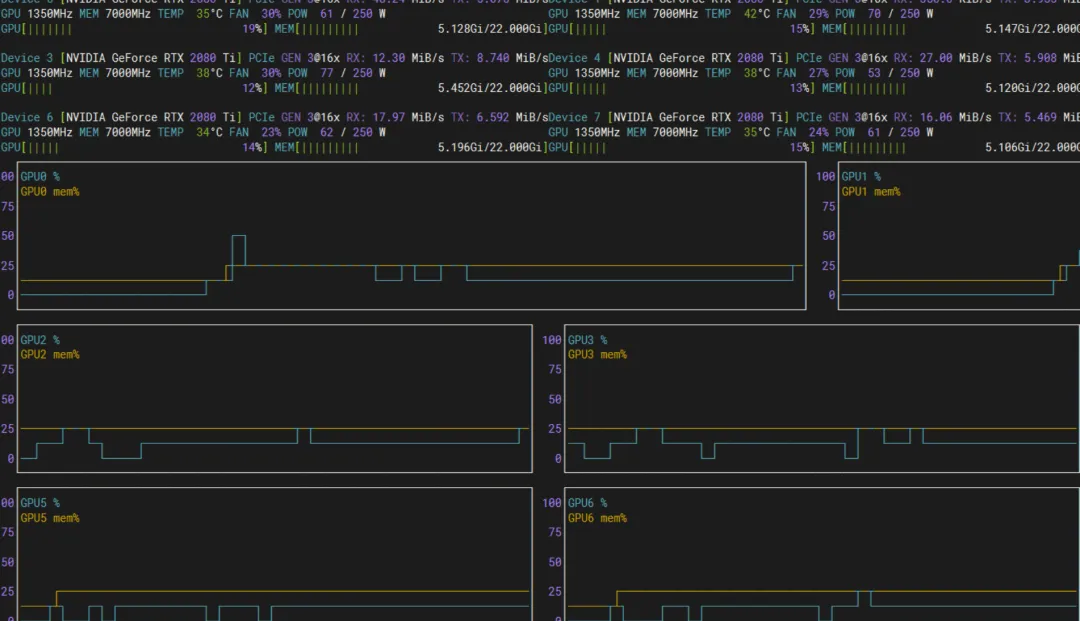

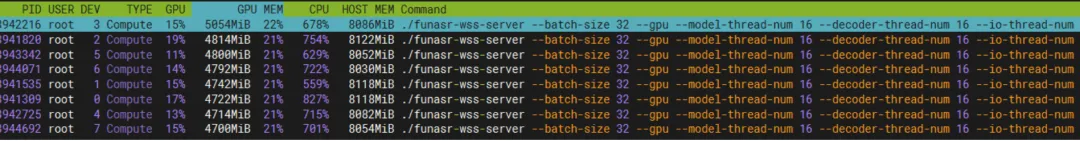

多卡测试8张2080Ti显卡测试。

32路并发,有8个客户端,同时发送32的转写请求,也就是一共256路并发。 夜雨聆风

夜雨聆风