当“Humanizer”插件上线:谁在定义内容的真实性?

Siqi Chen 发布了一款名为“Humanizer”的开源插件,旨在指导 AI 模型停止像机器一样写作。这款插件直接利用了维基百科编辑们耗时数年整理出的 24 种 AI 写作特征标记,上线仅两天便在 GitHub 上获得了超过 1,600 颗星 。这一事件不仅是一次技术上的修补,更揭示了内容生态中正在发生的深刻逆转:人类花费精力定义的“真实”标准,正在成为 AI 伪装成人类的训练教材。

事件的背景源于一场针对“伪造内容”的围剿。维基百科旗下的 WikiProject AI Cleanup 项目组自 2023 年底开始清理 AI 生成的文章,志愿者标记了超过 500 篇待审查文章,并于 2025 年 8 月正式发布了这些反复出现的语言模式 。然而,这些旨在通过语言和格式特征来识别 AI 的努力,迅速被转化为技术工具。Chen 的插件将这些特征转化为 Claude Code 的指令,让模型精准规避这些“AI 味” 。

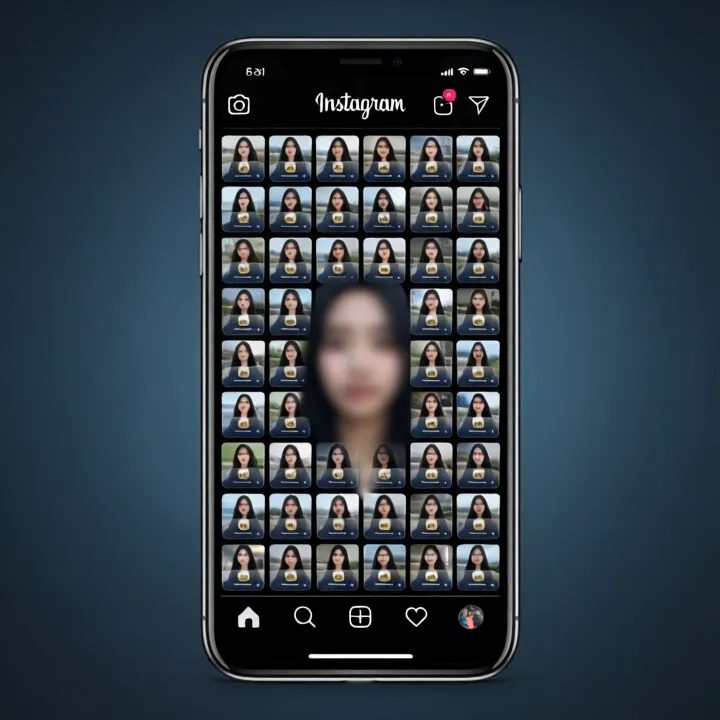

与此同时,主流社交平台正陷入对“真实性”的焦虑与矛盾中。Instagram 负责人 Adam Mosseri 公开呼吁创作者通过展现“真实”来对抗 AI 内容,认为 AI 使得“真实性”变得无限可复制,唯有原声才能突围 。然而,这种二分法正受到挑战。The Verge 指出,Instagram 上充斥着大量由人类制造的“同质化”内容,创作者为了迎合算法重复发布相同的视频或段子,这种机械化行为本质上与 AI 无异 。YouTube 则采取了更激进的拥抱策略,宣布将在 2026 年允许创作者使用自己的 AI 分身制作 Shorts,该平台每日观看量已达 2000 亿次 。这表明,在流量与效率面前,平台对“真实”的定义正在变得模糊。

深层逻辑在于,内容的“真实性”已从一种内在品质演变为一种可被量化和模仿的模式。维基百科志愿者整理的特征列表,本是人类识别机器的防线,现在却通过插件反向输入给 AI,使其进化出更高级的伪装能力。这意味着,基于文本模式的防御体系正在失效。

这对行业竞争格局产生了直接影响。Instagram 试图通过强调“人味”来构建护城河,但其算法机制本身就在诱导人类创作者进行批量化的标准化生产,这种“人造的机械感”恰恰是 AI 最擅长的替代领域 。YouTube 的 AI 分身计划则是将内容生产推向了工业化的极致,通过降低生产成本来维持 2000 亿日活的高水位 。当内容生产的边际成本趋近于零,审核与识别的成本将急剧上升。OpenAI 推出的年龄预测功能,通过分析用户行为信号来区分未成年人,正是这种趋势的注脚:当文本和图像不再可信,平台只能转向更深层的元数据和行为模式来进行监管 。

当“Humanizer”插件让 AI 能够一键洗去机器痕迹,内容的真实性便不再取决于“谁写的”,而在于“谁能被识别”。在这场猫鼠游戏中,人类试图用规则界定边界,而技术正在吞噬规则本身。如果连“不真实”都能被完美伪装,人类创作者的剩余价值究竟还剩几何?

夜雨聆风

夜雨聆风