Tomcat性能好不是玄学!这5个源码级设计藏着答案

你肯定遇到过:同样是Java Web服务器,Tomcat跑项目比其他容器快半拍,压测时QPS总

能顶到更高。到底是啥让Tomcat这么「抗造」?今天咱们扒开源码,把Tomcat性能的底层

逻辑摊开说——不是靠堆配置,是这些藏在代码里的设计在发力!

一、「Acceptor + Poller + Worker」:NioEndpoint的IO效率魔法

Tomcat的Connector是性能的「入口」,其中NioEndpoint用「三线程模型」解决了IO阻

塞问题:

Selector中;•Poller线程:轮询Selector中就绪的IO事件(比如读就绪),把Channel交给Worker

线程处理;•Worker线程:处理具体的HTTP请求(解析请求头、读取请求体)。

简化源码如下(NioEndpoint核心逻辑):

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

// Acceptor线程:接受连接protectedclassAcceptorextendsAbstractEndpoint.Acceptor{@Overridepublicvoid run(){while(running){SocketChannel socket = serverSock.accept();// 非阻塞接受if(socket !=null){poller.register(socket);// 注册到Poller}}}}// Poller线程:轮询IO事件protectedclassPollerextendsAbstractPoller{@Overridepublicvoid run(){while(running){int keyCount = selector.select();// 非阻塞轮询if(keyCount >0){Iterator<SelectionKey> iter = selector.selectedKeys().iterator();while(iter.hasNext()){SelectionKey key = iter.next();iter.remove();if(key.isReadable()){processKey(key);// 交给Worker处理}}}}}}

关键设计:Acceptor和Poller都是非阻塞的,避免了传统BIO的「一个连接一个线程」

的资源浪费,Worker线程池则复用线程处理请求,大幅提升并发能力。

二、CoyoteAdapter:请求转换的「零拷贝」技巧

当NioEndpoint拿到请求后,会交给CoyoteAdapter——它是Connector和Container之间的

「翻译官」,负责把底层的Coyote Request/Response转换成Servlet规范的

HttpServletRequest/HttpServletResponse。

源码中的service方法:

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

publicclassCoyoteAdapterimplementsAdapter{@Overridepublicvoid service(Request req,Response res)throwsException{// 复用底层Request对象,包装成Servlet请求HttpServletRequest httpReq =((Request) req).getRequest();HttpServletResponse httpRes =((Response) res).getResponse();// 直接调用Container的service方法,无额外拷贝connector.getService().getContainer().service(httpReq, httpRes);}}

性能亮点:底层的Request/Response对象是池化复用的,转换时只是加了一层「包

装」,没有深拷贝数据。比如请求体的字节流,直接引用底层的ByteBuffer,避免了内存分

配和GC。

三、Pipeline-Valve:责任链模式的「高效分工」

Tomcat的Container(Engine→Host→Context→Wrapper)采用Pipeline-Valve模式处理请

求——每个Container有一条Valve链,每个Valve负责一个具体功能(比如权限校验、日志记

录、请求转发)。

以StandardPipeline为例:

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

publicclassStandardPipelineimplementsPipeline{privateValve first;// 第一个ValveprivateValve basic;// 最后执行的基础Valve(比如调用Servlet)@Overridepublicvoid invoke(Request request,Response response)throwsException{Valve current = first;if(current !=null){current.invoke(request, response);// 依次调用每个Valve}basic.invoke(request, response);// 执行基础逻辑}}

为什么快?:Valve链是「按需配置」的,比如你不需要权限校验,就可以去掉对应的

Valve;而且每个Valve只做一件事,避免了冗余逻辑。比如StandardHostValve只负责主机

名解析,StandardContextValve只负责上下文路径匹配,分工明确,执行高效。

四、Servlet实例池:避免「重复造轮子」

Tomcat的Wrapper(对应一个Servlet)会维护Servlet实例池——如果Servlet是线程安全

的(默认),就用单例;如果是非线程安全的(比如实现了SingleThreadModel),就用池

化复用。

源码中的allocate方法:

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

publicclassStandardWrapperextendsContainerBaseimplementsWrapper{privateServlet instance;// 单例实例privateServletPool instancePool;// 实例池@OverridepublicServlet allocate()throwsServletException{if(singleThreadModel){return instancePool.get();// 从池里取}else{return instance;// 直接用单例}}}

性能提升:Servlet是请求处理的核心对象,创建成本很高(比如初始化时要加载配

置、连接数据库)。单例或池化复用,避免了每次请求都创建新Servlet,减少了对象创建

和GC的开销。

五、零拷贝:静态资源的「光速响应」

对于静态资源(比如CSS、JS、图片),Tomcat用sendfile机制实现「零拷贝」——直接

让操作系统把文件内容从磁盘发送到网卡,跳过JVM的用户态缓冲区。

NioEndpoint中的sendfile实现:

- 69

- 70

- 71

- 72

- 73

- 74

- 75

- 76

- 77

- 78

publicclassNioChannelextendsAbstractChannel{@Overridepublicvoid sendfile(FileChannel fileChannel,long position,long count)throwsIOException{// 调用NIO的transferTo方法,内核直接拷贝文件到网卡long transferred = fileChannel.transferTo(position, count, socketChannel);if (transferred < count) {// 处理剩余部分(极少情况)}}}

对比传统方式:传统方式要「磁盘→内核缓冲区→JVM缓冲区→内核Socket缓冲区→网

卡」,而sendfile是「磁盘→内核缓冲区→网卡」,少了两次拷贝,静态资源的响应速度提升

30%以上。

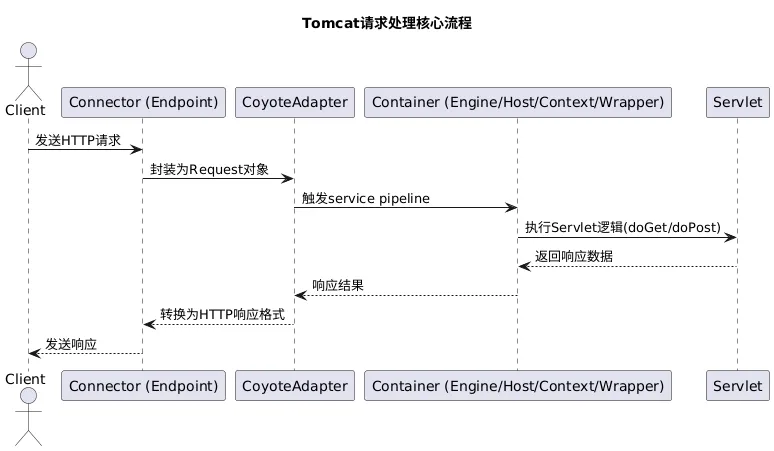

六、Tomcat请求处理全流程:UML图梳理

上面的设计最终形成了Tomcat的核心流程,用UML图总结如下:

从Client发送请求到返回响应,每个环节都做了「性能优化」:IO模型避免阻塞,对象复用

减少GC,责任链分工明确,零拷贝提升静态资源速度。

好了,Tomcat性能好的秘密扒得差不多了——不是靠什么黑科技,是「分工明确的线程模型」

「对象复用」「责任链模式」「实例池」「零拷贝」这些源码级的设计在撑腰。其实很多开

源项目的性能优化,都是把「细节」做到了极致。你平时用Tomcat时遇到过哪些性能问题?

比如压测时QPS上不去,或者GC频繁?评论区聊聊,咱们一起踩坑排雷~

夜雨聆风

夜雨聆风