我用这个开源插件,在OpenClaw中把AI调用成本砍了 70%

你有没有算过一笔账?

上个月,我的 AI 账单是 $127。GPT-5 Codex 调用了 3,200 次,Claude Sonnet 4.5 调用了 180 次。

但当我翻看对话记录时,发现了一个扎心的事实:

-

“好的” —— GPT-5 Codex -

“谢谢” —— GPT-5 Codex -

“今天深圳天气怎样” —— GPT-5 Codex -

“翻译一下:Hello world” —— GPT-5 Codex -

“讲个笑话” —— GPT-5 Codex

超过 60% 的对话,根本不需要 GPT-5 Codex 的能力。

一个能写操作系统、解数学证明、设计分布式架构的模型,被我用来回了一句”好的”。

这就像开兰博基尼送外卖——能送,但没必要。

问题的本质:模型的”能力溢价”

大模型按 token 收费,能力越强价格越贵:

|

|

|

|

|

|---|---|---|---|

| Claude Sonnet 4.5 |

|

|

|

| GPT-5 Codex |

|

|

|

| Kimi K2.5 |

|

|

|

数据来源:Anthropic 官网、OpenRouter、Moonshot AI 平台

从 Kimi K2.5 到 Claude Sonnet 4.5,输出价格差 10 倍。

但我们使用 AI 时,往往”一刀切”——不管问什么,都丢给最强的模型。

原因很简单:没人愿意每次对话前先想一遍”该用哪个模型”。

直到月底看到账单。

解决方案:让 AI 自动”看人下菜碟”

我做了一个开源插件:claw-router。

它的核心逻辑只有一句话:

不是”哪个模型最好”,而是”这个任务该用什么级别的模型”。

claw-router 在你发消息的瞬间,自动判断这句话有多复杂:

-

你说”hi” → 路由到 Kimi K2.5(¥0.002/次) -

你说”帮我写个 Python 脚本” → 路由到 GPT-5 Codex(¥0.07/次) -

你说”设计一个支持千万并发的缓存架构” → 路由到 Claude Sonnet 4.5(¥0.11/次)

全程自动,你什么都不用管。

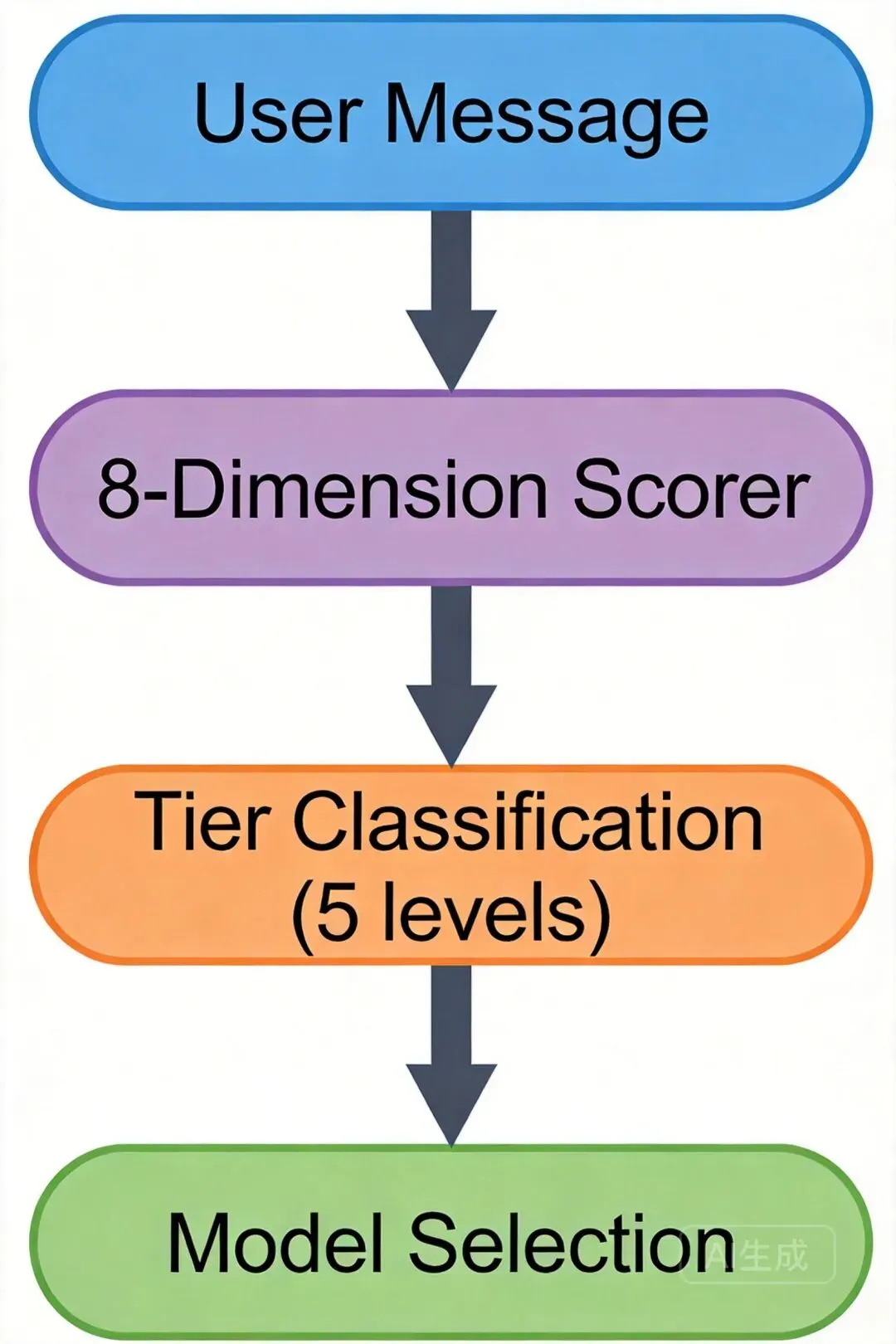

它是怎么工作的?

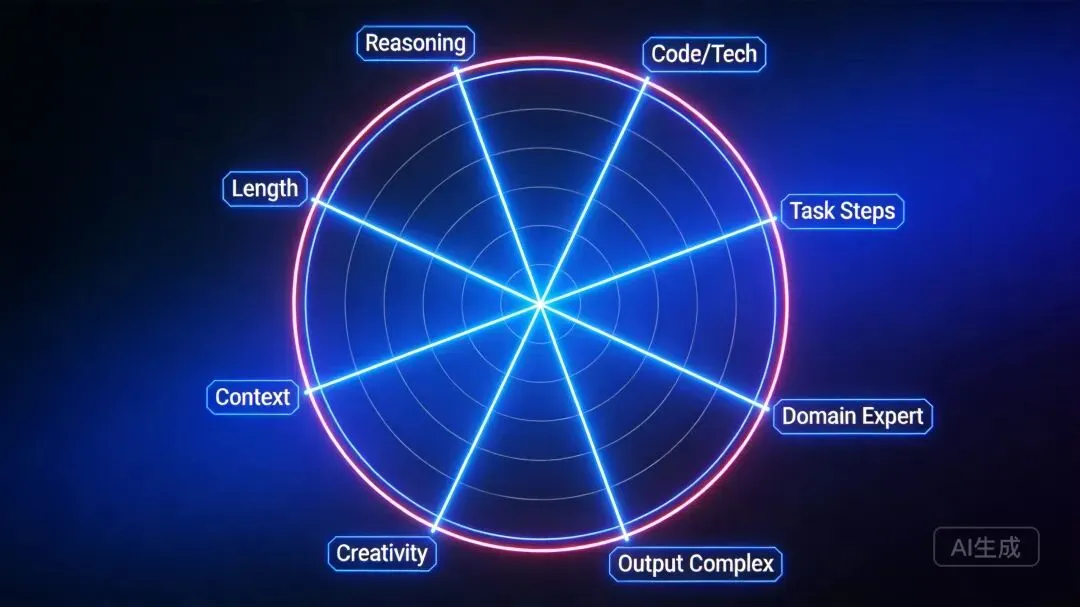

第一步:8 维度评分引擎

claw-router 会从 8 个维度分析你发的每一句话:

-

推理深度(20%) —— 简单回答还是逻辑推导? -

代码/技术(18%) —— 涉及编程吗? -

任务步骤(15%) —— 单步问题还是多步流程? -

领域专业度(12%) —— “量子计算”还是”今天吃什么”? -

输出复杂度(10%) —— 一句话就够,还是要生成 JSON? -

创意要求(10%) —— 查个事实还是写小说? -

上下文依赖(8%) —— 需要理解之前的对话吗? -

消息长度(7%) —— 长消息通常更复杂

每个维度独立打分 0~1,加权求和后校准输出最终分数。

纯本地计算,< 1ms,零 API 调用。

第二步:5 级任务分级

根据分数,任务被归入 5 个等级:

|

|

|

|

|

|---|---|---|---|

| TRIVIAL |

|

|

|

| SIMPLE |

|

|

|

| MODERATE |

|

|

|

| COMPLEX |

|

|

|

| EXPERT |

|

|

|

第三步:查表,路由

最后一步最简单——查配置表,找到等级对应的模型,发送。结束。

硬规则:特殊情况直接判定

有些消息不需要评分,直接秒判:

-

消息 ≤ 5 字且无技术词 → TRIVIAL -

包含 3+ 代码块 → COMPLEX -

出现”系统设计””架构设计””从零搭建” → EXPERT

这些”硬规则”优先级最高,确保边界情况不出错。

实际效果:我的账单变化

使用 claw-router 一个月后:

|

|

|

|

|

|---|---|---|---|

|

|

|

|

-72% |

|

|

|

|

-75% |

|

|

|

|

|

| 月度总成本 | $127 | $38 | -70% |

用户体验呢?完全一样。

因为简单对话本来就感知不到模型差异。”今天天气怎样”用 GPT-5 Codex 还是 Kimi K2.5 回答,结果是一样的。

配置灵活:3 个模型够用,9 个也行

3 个模型的实用配置:

{"tiers": {"TRIVIAL": { "primary": "moonshotai/kimi-k2.5" },"SIMPLE": { "primary": "moonshotai/kimi-k2.5" },"MODERATE": { "primary": "openai/gpt-5-codex" },"COMPLEX": { "primary": "openai/gpt-5-codex" },"EXPERT": { "primary": "anthropic/claude-sonnet-4.5" }}}

9 个模型的豪华配置(每级配 fallback):

{"tiers": {"TRIVIAL": { "primary": "ollama/llama3", "fallbacks": ["moonshotai/kimi-k2.5"] },"SIMPLE": { "primary": "deepseek/chat", "fallbacks": ["moonshotai/kimi-k2.5"] },"MODERATE": { "primary": "openai/gpt-5-codex" },"COMPLEX": { "primary": "openai/gpt-5-codex", "fallbacks": ["anthropic/claude-sonnet-4.5"] },"EXPERT": { "primary": "anthropic/claude-sonnet-4.5", "fallbacks": ["openai/gpt-5.2-codex"] }}}

加模型?改一行配置。不动任何代码。

安装:一行命令

openclaw plugins install @aiwaretop/claw-router测试路由:

openclaw route test "帮我写一个 Python 爬虫"# → { tier: "COMPLEX", model: "openai/gpt-5-codex", score: 0.68 }

查看统计:

openclaw route status最后

AI 时代,算力就是钱。

claw-router 解决的问题很实际:在保证体验的前提下,让每一分钱花在刀刃上。

不是每个问题都需要最聪明的模型。有时候,”刚好够用”就是最好的。

开源地址: https://github.com/HackSing/claw-router (点击原文直接跳转)

欢迎 Star ⭐ 支持,Issue 和 PR 随时欢迎。

夜雨聆风

夜雨聆风