智能化软件开发微访谈·第四十二期 AI将要吞噬软件了吗?

CodeWisdom

AI将要吞噬软件了吗?

微访谈 · 第四十二期

背景介绍

OpenAI联合创始人Andrej Karpathy所提出的“软件3.0”所强调的“提示词即程序”、“LLM成为新一代软件的操作系统”等观点所引发的“AI吞噬软件”的口号流传甚广。近期,Anthropic为Claude Cowork植入11款与财务、销售、法律等行业相关的“新插件”,进一步引发新一波热潮,“血洗全球软件业”、“软件世界大熔断”、“中间层被压扁”等言论不绝于耳,甚至舆论广泛认为这就是1月底以来全球软件和服务业股价暴跌的主要原因。与此同时,OpenClaw作为一个能够自主接管电脑、全天候自行处理任务的开源“智能体引擎”也在个人智能体领域掀起巨浪。那么,传统软件(特别是SaaS软件)是否真的会逐渐消亡?未来的智能化软件系统技术栈会发生什么样的变化?其主流形态是“模型操作数据”还是“模型+代码”的共生体?传统软件(特别是SaaS)的“不可替代价值”究竟是什么?中国软件产业和广大软件工程师应当如何迎接这场智能化变革?围绕这些问题,我们邀请了多位一线技术专家齐聚一堂展开探讨和交流,希望能够帮助大家更好地理解智能化发展浪潮中软件技术及软件产业的未来发展方向。

主 持 人

彭鑫

复旦大学

复旦大学计算与智能创新学院副院长、教授,国家级高层次人才计划入选者。中国计算机学会(CCF)杰出会员、软件工程专委会副主任、开源发展委员会常务委员,中国汽车工程学会汽车基础软件分会副主任,《Journal of Software: Evolution and Process》联合主编(Co-Editor),《ACM Transactions on Software Engineering and Methodology》、《Empirical Software Engineering》、《Automated Software Engineering》、《软件学报》等期刊编委。2016年获得“NASAC青年软件创新奖”,2023年入选上海市东方英才拔尖项目,2024年获得“中创软件人才奖”。主要研究方向包括软件智能化开发、AI原生与云原生系统、泛在计算软件系统、智能汽车及工业软件等。研究工作多次获得IEEE Transactions on Software Engineering年度最佳论文奖、ICSM最佳论文奖、ACM SIGSOFT杰出论文奖、IEEE TCSE杰出论文奖等奖项。担任2022年与2023年CCF中国软件大会(CCF ChinaSoft)组织委员会主席与程序委员会共同主席,以及ICSE、FSE、ASE、ISSTA、ICSME、SANER等会议程序委员会委员。

访

谈

嘉

宾

王昊奋

同济大学

同济大学特聘研究员,博士生导师。他是全球最大的中文开放知识图谱联盟OpenKG发起人之一。他负责参与多项国家级AI相关项目,发表100余篇AI领域高水平论文。他构建了全球首个可交互养成的虚拟偶像—“琥珀·虚颜”;所构建的智能客服机器人已累计服务用户超过10亿人次。目前,他担任中国计算机学会术语工委副主任,自然语言处理专委会秘书长,中国中文信息学会理事,大模型专委会执委,语言与知识计算专委会副秘书长,上海市计算机学会自然语言处理专委会副主任等社会职位。

茹炳晟

腾讯Tech Lead

腾讯Tech Lead,腾讯研究院特约研究员,腾讯集团技术委员会委员,中国计算机学会(CCF)TF研发效能SIG主席,“软件研发效能度量规范”团体标准核心编写专家,中国商业联合会互联网应用技术委员会智库专家,中国通信标准化协会TC608云计算标准和开源推进委员会云上软件工程工作组副组长,国内外各大技术峰会的联席主席,出品人和Keynote演讲嘉宾,公众号“茹炳晟聊软件研发”主理人,二十余本技术畅销书的作者和译者。

肖然

Inspire Group

Inspire Group数字化专家、中关村智联联盟秘书长,长期深耕企业数字化与智能化转型,专注于AI、敏捷开发、DevOps及数据驱动创新。作为金融科技与数字化转型专家,他担任《财新》《数字银行》专栏作者,并为中行、招行、华为等企业提供战略咨询。近年来,他聚焦“软件3.0时代”下AI技术的行业落地,在TiD、InfoQ等顶级技术峰会发表主题演讲。同时,他积极推动技术社区生态建设,联合发起中国敏捷教练企业联盟(CAC)和DDD China,促进前沿技术在国内的普惠发展。作为上海交通大学高金学院讲师及工商银行研修院特邀专家,他致力于AI人才培养与行业赋能,助力企业探索高价值AI场景。

毛剑

腾讯云架构师技术同盟主席

腾讯云架构师技术同盟主席

沈欣

半天妖集团

半天妖集团CIO,担任腾讯TVP智慧零售行业大使、腾讯云架构师联盟理事,广东省连锁经营协会技术委员会联席主席,弯弓研究院联席院长、一级研究员,中国数字化营销50人论坛发起人,中国信通院低代码/无代码推进中心技术专家,中国饭店协会餐饮数字化专业委员会技术专家等职务。曾任喜茶数字化高级副总裁、百果科技首席技术市场官,百果科技首任轮值主席、和君咨询合伙人。多次担任太盟、红杉、中信等投资基金IT顾问,负责对投资企业进行尽调及投资后IT规划。为爱尔眼科、协鑫、Intel、中科院硅酸盐研究所、兴业银行、长沙农商行、绿能慧充、药易购、UR、Tea’stone、久久丫、真功夫快餐、星巴克、万客隆(中国)、好又多、中油BP、OK便利店、周大福、本来生活等企业进行过数字化规划、开发及咨询。

王楠

前Jina AI联合创始人兼CTO

王楠博士专注于AI技术在NLP和搜索领域的实际应用,其主导开发包括jina-embeddings在内的多个开源模型全球累计下载量超2000万次。作为2023中国开源先锋33人和LF AI&Data基金会TAC成员,他热衷于AI开源社区建设,累计贡献40余场讲座。其参与创始的Jina AI作为全球领先的AI搜索模型提供商于2025年被Elastics(NYSE: ESTC)收购。

朱征宇

上海流程智造科技创新研究院

上海流程智造科技创新研究院(国家流程制造智能调控技术创新中心)常务副院长,致力于打造国产自主的关键工业软件产品。曾任惠普公司上海全球软件研发中心主任,主导研发业界领先的企业级软件产品。

王禹程

金蝶2030实验室

金蝶2030实验室副总经理,长期从事企业级软件与 AI 相关工作,具备产品、技术与组织管理的复合经验。熟悉数据体系与智能化应用建设,曾负责复杂系统规划与跨团队协作,注重技术与业务目标的协同,推动规模化落地与持续演进。

谢吉宝

Qoder

Qoder资深技术专家,AI Coding 领域探索者,深耕基础架构领域多年,曾主导多款核心中间件与高可用产品的架构设计,成功推动多次大规模系统演进,拥有深厚的技术积淀与管理经验。目前聚焦于 AI Coding 赛道,主要负责 Qoder CLI、Quest 及 QoderWork 的技术创新与迭代,主张打破传统开发边界,专注于通过 AI Coding 打造新一代生产力工具,定义并构建面向未来的工作新范式。

访谈主题

01

近期Claude Cowork植入11款“新插件”以及OpenClaw爆红引发了大量讨论。对此您有什么直观感受和体验?它们在核心技术或者产品设计有什么新的突破吗?

02

未来的智能化软件系统技术栈会发生什么样的变化?其核心形态是“模型操作数据”还是“模型+代码”的共生体?

03

传统软件的“不可替代价值”究竟是什么?这一点对于2B(如以SaaS为代表的企业信息化系统)和2C(如个人手机和桌面助手)软件有什么不同?这些软件是否真的会随着大模型和Agent等AI技术及其应用的发展逐渐消亡?或者其中哪些部分会被AI吞噬,哪些部分将得以保留甚至加强?

04

大模型与Agent在2B和2C软件中的广泛应用将带来什么样的风险和挑战?为此需要加强哪些方面的技术研究和实践探索?

05

您如何看待未来五到十年软件领域的智能化变革?中国软件产业和广大软件工程师应当如何迎接这场变革?

Q&A记录

Question 1

主持人:近期Claude Cowork植入11款“新插件”以及OpenClaw爆红引发了大量讨论。对此您有什么直观感受和体验?它们在核心技术或者产品设计有什么新的突破吗?

王昊奋:

我的直观感受是:AI 终于从“聊天框里的智者”变成了“桌面上的打工人”。Cowork和OpenClaw的表现把“Agentic Workflow”彻底工程化了。

Anthropic 并没有为每个行业建立复杂的专有模型,而是通过“结构化工作流指令”将 Claude 的泛化能力锚定在特定场景,实现了从 API 逻辑转向业务逻辑的设计突破。此外,Claude Cowork 实现了在本地或隔离环境下的代码与数据处理。这种“数据在本地流转、逻辑在云端生成”的模式,解决了企业级应用最头疼的隐私与安全合规问题。

OpenClaw则代表着极致的“本地主权”与“主动性”,一改传统 AI 的“拨一下动一下”,通过主动轮询机制,在后台监测邮箱、GitHub 或日程,并在检测到关键触发点时主动采取行动;深度集成了 Anthropic 的 Computer Use 能力,这意味着它不再依赖厂商是否开放了 API;同时以 IM 为终端,直接桥接到 WhatsApp、Telegram 或 Slack,直接诠释了最好的 UI 就是没有新 UI。

观点讨论

@彭鑫:@王昊奋 能否解释下“结构化工作流指令”?

@彭鑫:@王昊奋 OpenClaw这种过于主动的做法是否有严重的副作用?抛开安全风险不谈,它如何识别用户IM信息中哪些是希望Agent去干的哪些是闲聊甚至发牢骚?

@王昊奋:简单来说,结构化工作流指令(Structured Workflow Instructions)不再是让 AI “凭感觉”写一段话,而是给它一套标准作业程序(SOP)。这套指令将复杂的业务场景拆解为可预测、可验证的逻辑步骤,是 Anthropic 在企业级应用(尤其是 Claude for Enterprise )的核心逻辑。

@王昊奋:包括角色定义 (Role),思维链 (Chain of Thought)以及工具调用规范 (Schema)等

@彭鑫:@王昊奋 OpenClaw这种过于主动的做法是否有严重的副作用?抛开安全风险不谈,它如何识别用户IM信息中哪些是希望Agent去干的哪些是闲聊甚至发牢骚?

@王昊奋:如果 Agent 过于主动,它可能会从“生产力工具”降级为“数字噪音源”,更像一个“爱插嘴的同事”。容易认知负荷过载,每一句感叹或吐槽都给出行动方案,用户需要不断花精力去关闭、拒绝或修正行为,这是不可想象的。另外,从交互逻辑或产品心理的角度来说,当用户不再确定“哪一句话会触发 AI 动作”时,会产生一种不敢说话的心理压抑感。

茹炳晟:

这波Claude Cowork和OpenClaw的热度,以及千问点奶茶,我感觉并不是颠覆性的技术革命,从实现的底层原理看,2023年OpenAI搞Plugin那会儿就已经定调了,无非是模型发指令、外部去执行。那为什么现在突然全民热议?我觉得就俩原因:一是“千问点奶茶”这个场景选得太绝了,一下子把AI从极客的脚本工具拉成了人人都想使唤的跑腿小弟;二是工程打磨终于追上了想象力,跨插件的状态记忆不中断了,视觉点击也稳定到能秀demo了。所以与其说这是范式突破,不如说是同一套技术终于通过工程手短从“勉强能用”熬到了“愿意用”。

真正的突破并不在原理层,而在产品形态上的创新,大家终于不再关心模型有多聪明,而是开始问:它能不能帮我省事儿。这本质上是产品经理的胜利,从产品视角看找到了技术能力与大众欲望之间的最短路径。所以我的观点是要剥离“技术神话”的光环,将其置于技术成熟度曲线与大众认知拐点的交汇处来看这个事情,这次热潮的核心驱动力并非底层技术得质变,而是交互场景锚点下沉到了普通老百姓,普罗大众第一次产生了“这东西与我有关”的情绪共鸣。

观点讨论

@赵俊民:生态闭环很重要,今天跟荣耀一个兄弟讨论了这个,荣耀最早提出了端侧AI自动驾驶功能,但是没有实现商业闭环

@赵俊民:千问算是商业闭环的一个案例,互联网比手机公司利润高,掌握生态多,更好实现

@茹炳晟:产品的想法够讨巧@肖然:最近在2C和2B同时爆发确实还是很震撼,Cowork确实从“岗位助手”到了“领域专家”;OpenClaw在客户本地落地了智能体。

@陈治:但商业模式是个问题。各家大厂都不会轻易交出控制权的。并不是纯粹是技术的事情。技术能办到,但是利益不能打通,负面的安全问题不能完全解决。也难以走通。

@茹炳晟:完全正确

毛剑:

Claude 直接冲击了SaaS,真正看到了对软件行业的巨大变革。我觉得 Agent 本身在数据孤岛系统之间可以彻底打通和流动。

而且从SaaS标准化、定制化,业务适配的范式切换到,由LLM大模型来驱动流程和规划,反过来适配业务,可以说是巨大的革命。

OpenClaw出来之前我们也一直在思考内部需要一个怎样的平台来让所有员工享受AI的便利,但发现都需要很多定制Agent,即使是低代码平台拖拉拽也需要有一定的开发门槛。最大的突破在于生成代码执行一切+本地,这样每一个员工可以完成自己的Skills,工作流程,就是一个适配自己私人的个人助理,这是无论怎么样的通用平台都无法做到的,只需要企业对内有合适的API、MCP等。

沈欣:

我觉得做了部分工程化,但是彻底工程化就有点过了。现在反而是最危险的时候。人和AI的结合没看到真正的好例子。即使是模型维护的“工作记忆区”,也没看到可承载大型企业多人协作下持续的知识能力,至少看来还欠缺

1)可普适落地的理论和方法论

2)适合中国企业的理论和方法论

3)对幻觉真正有效的抑制和控制

观点讨论

@肖然:感觉两者还是产品做得更好了: Claude Cowork 胜在产品化封装,将AI能力精准注入企业核心业务流程,直接挑战传统应用软件的价值。OpenClaw 胜在架构开放性,提供了一个可扩展的智能体运行时,让每个人都能低成本拥有高权限的私人数字助理。

@沈欣:产品更好了没问题,但还是量变,没看到质变

@茹炳晟:我感觉我们要特别关注这波热潮背后的隐性风险,比如Claude Cowork和OpenClaw误操作的责任归属问题,谁为失败买单?toC和toB应该都没法回避这个问题。对于toC场景,OpenClaw因识别错误在电商App下单了错误商品,是用户承担退货成本,还是开发者赔偿?toB场景风险就更大了,一旦涉及金融交易、医疗建议、法律文书,现有技术栈的防御能力和反脆落能力估计都还没做好准备。奶茶场景本质上回避了这个问题,我其实都没有点单成功[捂脸]

@沈欣:我以前定义数字员工和AI助理的区别,就在于能否“主动”发起流程,目前看来还是一个高级的AI助理而已

@彭鑫:是,目前看起来还是一帮狂热拥趸先无所顾忌的用上了,但确实起到了很大的推波助澜的作用

@王昊奋:识别用户IM信息中本质是一个意图识别,这块大模型或专用小模型都可以胜任。无非就是Actionable (可执行意图),比如“帮我订张票”、“总结一下昨天的周报”;Informational (信息同步),比如 “我刚才把文档更新了”;或Expressive (情感表达/牢骚),如 “这项目真让人头大”、“今天天气不错”。只有当可执行的阈值足够高,Agent才会启动。

@彭鑫:是的,这会是个很大的问题

@沈欣:不够不够,我觉得要AI主动说下周有台风,你不如取消行程

@王昊奋:可以去看一下Lex Fridman对Peter Steinberger的访谈

@肖然:Anthropic 工程化还是在持续,一系列元模型定义@王昊奋:@沈欣 还是意图识别,无非是隐式的,或者多轮的长Context。他没有变化这样一个任务,仅仅是让识别或分类的难度变高而已。

@沈欣:主动提出,我们应该针对某类用户做营销这样可以处理库存并且提升下月的营业额,毛利率下降的问题需要和HR管理KPI的同事商量一下做点调整

@茹炳晟:隐性风险是谁为潜在的失败决策买单

王楠:

最近这段时间我的感觉是回到了23年年初ChatGPT发布后的那个春节。在我看来openclaw是claude code的破圈,类似chatgpt是gpt 3.5的破圈。cc从25年5月22日向max用户开放之后,就开始在程序员圈内快速传播,尤其是11月Claude 4.5发布之后,cc的效果进一步增强,不仅可以完成局部feature的实现,更可以实现整个复杂项目的。Opus 4.6发布之后,cc更是可以完成C编译器这样的复杂编程项目。

朱征宇:

Claude Cowork是一个很好的AI在企业场景的落地应用:

1. 企业应用中,合规是底线, Claude Cowork通过引入本地沙箱基本做到了合规安全。除了两个小瑕疵:一、提示词注入方面比较脆弱;二、不承担责任。

2. 云端大脑(模型)和本地手脚(在沙箱内)的协同,与工业场景的云边协同的思路异曲同工。

3. 通过屏幕操作(Computer Use)实现与遗留企业软件(Legacy Systems)集成,从而对于存量客户友好。

王禹程:

我把 Cowork 插件和 OpenClaw 爆红看作同一趋势的两面:Agent 从“会聊”走向“会做”。Cowork 的关键不在“多了 11 个功能”,而在把技能/连接器/命令/子代理打包成文件化插件,把企业 SOP 资产产品化、可复用。 OpenClaw 则让“本地执行 + 技能生态”走向大众,但也把安全账单提前摊开:配置不当会带来重大安全风险,技能市场已出现恶意扩展传播窃密软件。这对于toB市场不易接受

谢吉宝:

我的直观感受这波热度的本质不是“又多了几个插件”,而是把AI从聊天窗口拉进了真实工作流:能读你的数据、能调你的工具、能把结果写回去。

体验上最大的变化是:以前是“我问你答”,现在更像“我交代任务,你自己跑流程”。

要说核心突破,我觉得主要在产品范式的转变:

– 从能力到闭环:不是单点回答更聪明,而是“调用工具—拿到结果—再决策—再调用工具”的链路更顺了。

– 产品形态更像‘协作空间’而不是‘插件市场’:插件只是接口,真正改变体验的是工作台式的编排、上下文共享、权限和成果沉淀。

Question 2

主持人:未来的智能化软件系统技术栈会发生什么样的变化?其核心形态是“模型操作数据”还是“模型+代码”的共生体?

王昊奋:

未来的智能化软件系统技术栈正经历从“确定性逻辑”向“概率性推理”的底层重构。结合当前技术趋势和昨天与彭老师、晨曦一起撰写的《Agent狂欢与Palantir爆红背后:智能化软件正在“凤凰涅槃”》文章,我想多说几句。这一变化可以从以下两个维度理解。

1. 技术栈正在经历从“逻辑中心”到“目标中心”的范式转移。我们都知道,传统的软件栈(如 MVC 架构)核心是代码定义的逻辑,开发者需要预设所有可能的路径。而未来的技术栈将以模型推理(Reasoning Engine)为内核。交互层从 GUI转向 NUI(自然界面)或“无界面”的主动代理;逻辑层从“硬编码(Hard-coded rules)”转向“即时规划(On-the-fly planning)”,模型不再只是功能插件,会扮演系统调度器的角色;而数据层则从单纯的 CRUD(增删改查)转向“知识索引与长效记忆(RAG + Memory)”。

2. 核心形态我认为是高度协作的“模型+代码”共生体。其中,模型负责理解模糊的用户需求,将其拆解为任务步骤。它解决了代码无法处理的“长尾场景”和“非结构化理解”;在涉及精密计算、数据库事务、安全鉴权等领域,代码是必不可少的“确定性围栏”,模型通过调用代码模块(Tools/APIs)来确保结果的可靠性和低能耗。共生逻辑打个比方,模型就像“大脑(中枢神经)”,而代码则是“四肢(肌肉执行)”和“反射弧(标准化 SOP)”。

茹炳晟:

我的理解未来技术栈的核心形态既不是“模型操作数据”,也不是简单的“模型+代码”拼一块儿,而是一个三层分工的共生体。以前的“旧三层”是前端(交互)→ 后端(逻辑)→ 数据库(存储)。而现在的“新三层”是意图层(大模型+Prompt模板)、编排层(Agent框架+工作流引擎)和执行层(传统代码+API+低代码组件)。大模型在顶层负责理解模糊意图、拆解任务,中间加一层轻量的“编排沙箱”来管理状态和决策轨迹,负责多工具调度、状态管理、容错。底层还是靠传统代码干那些确定性的事,确保事务一致性、安全审计等要求,比如算钱、改数据库、保合规。

毛剑:

我说的简单一点,我倾向是模型+代码驱动数据的模式,模型擅长规划、思考,用确定性生成的代码、或者已有的工具平面来执行(actor),最终完成对数据的操作。

肖然:

我认为关键是三种软件的共生问题,Software 1.0很稳,骨架还得是这个。Software 2.0和3.0再各司其职

沈欣:

把AI看成一群全科的博士即可。

一个博士来到企业,不可能立刻创造生产力,他需要

1)了解企业架构、流程

2)了解行业,正向和反向经验(为什么这么做,为什么不那么做)

3)了解行业边界

4)可以访问企业的真实数据

通过“数智库”这种本体论的载体,才可以发挥AI的价值一定是模型自动化+代码+人决策混合模式

未来应该是:

所有的需求,应该以本体论的方式存在于一个企业数智库中

AI 根据数智库的内容进行自动软件开发

AI根据业务真实产生的数据,主动、自动的迭代数智库

AI根据迭代后的数智库建立新的分支并进行AB Test

AI+软件+数据,数智库真正的变成了“企业大脑”,驱动企业商业模式的迭代

观点讨论

@彭鑫:嗯,其实我们谈模型、代码还不够,还得human in the loop:关键环节还需要人参与意图确认、问题纠正、能力补足等。前几天群里转的公众号说的AI开始给人派众包任务就是这个意思。

@王昊奋:只会变得更复杂,对架构,工程化和产品的要求更高

@彭鑫:确实,这种新型智能化系统的架构设计是神经符号融合的,难度和挑战可能比过去更高了

王楠:

我也认为未来软件的基本形态是“模型+代码”。agent使用LLM作为大脑,使用代码作为使用计算机的工具。模型负责调度、编排、输入和输出。通过代码和数字世界进行精准交互。这件事情之所以现在可以实现,核心在于LLM让思考和决策的成本变得非常低。同时也带了新的问题。因为LLM本身还是一个概率模型,所以结果的随机性是注定无法改变的。也就用了前面说的奶茶点错了谁类负责的问题。

朱征宇:

让我们把视角从软件、数据、模型提升到硬件和软件、AI和人类协同的维度来看。不管是’软件”还是”硬件”,不管是“模型”还是“数据”,都是帮助人类从自动化(automative,减少重复劳动)、发展到自适应(adaptive,根据环境做出响应),走向自主化(autonomous,根据对物理世界规律的“理解”做出判断)。

为了达到这个目标,硬件、软件、AI是互补的:“软件定义”可以让“硬件资源”实现软件的灵活性,比如软件定义网络(通信)、CPU(计算)、内存(缓存);而嵌入到硬件深层的软件可以提升软件的运行效率和可靠性;AI的“分析能力”可以帮助软件和硬件在全生命周期提升质量。

硬件、软件、AI是协同的:一、通过传感器和执行器,闭环数字世界和物理世界,通过“感知-分析-控制-反馈“逐步迭代,从不确定的过程获得结果的确定性。比如,开车的目的地是确定的,但是每一个时刻是动态规划(不确定的)的。AI的不确定性源于幻觉、不可解释、不可观察,可是AI善于给出”初值范围“;代码的确定性在于可重复的逻辑,不确定性在于代码的缺陷和执行时刻的不确定;硬件是最确定的,因此最基本的原子操作必须交给硬件。

AI Agent在“版本迭代“方面可以很强大。比如,一个Agent负责写代码,一个负责写unit test,一个负责code review(语法树检查),一个负责CICD(扫描、编译、合并、回滚、部署、测试等)。只要定义了功能和质量指标,通过模型互博,代码(模型)就可以自己生成、自己编译、自己测试、自己评审、自己部署、自己运行。反复迭代,放弃更差的,保留更好的。

我们对于世界的理解都是模型(代码是模型、文字也是模型)。语言模型(自然语言、代码、markdown)、概率模型(时序模型、大语言模型)、机理模型(热力学定理、流体力学定理)从各自独立的视角刻画世界,相互验证,交互融合。

理想的模型是内生的混合模型:负责收集事实和数据的模型,不能有幻觉,不应该基于概率模型;推理模型应该具有真正的因果推理能力;大模型最擅长从大量资料综合;需要创造性思维的模型,在空间距离上,某个维度相似,其他维度差异巨大;用于计算的模型应该独立(比如1+1=2,或者更为复杂的代数微分方程,不应该使用注意力机制)。这样各类模型分工协作,各自做擅长的事情。

另外,模型应该做得更小、能耗更低,每个人的口袋里都有一个模型。模型可以云边协同:云端一个大模型(老师模型),而边缘侧是云端大模型的代理(surrogate)小模型(学生模型)。云侧和端侧的模型既可以不联网独立运行,也可以联网相互协同。

观点讨论

@茹炳晟:现在很多人争论谁主谁次,我感觉其实争偏了,真正要命的问题是两个运行时环境怎么协作:模型是概率推理,代码是精确执行,这俩原本水火不容,难就难在中间那个层,既要让模型调用代码时不捅娄子,又不能让代码的刚性把模型的灵活劲儿全框死了。所以未来技术栈的胜负手,不仅在于模型多强、代码多快,而是谁能把“让会犯错的大脑指挥精准的肢体”这件事做得最自然、最便宜、最难出事故,同时在必要的时候能够召唤人类(HITL)

@茹炳晟:再往深想一层,现在大家默认底层那层“干脏活累活”的确定性代码还是人写的,但如果我们激进一点,这个假设很可能在未来几年被冲垮。当Agent自己能写代码、测代码、修代码,并且能根据运行时反馈动态替换自己的实现时,整个技术栈的底层逻辑就变了。那时候软件系统就不再是“三层建筑”,而是一个自我演化的生态:你今天写死的一个业务规则,明天Agent觉得效率太低,可能就自己给你重构了。这事儿听起来很酷,但细思极恐。第一,代码不再是契约,而成了瞬时的策略表达,你没法审计一个昨晚刚生成今早又消失的函数;第二,系统的确定性会从“数学级的保证”退化成“统计级的凑合”,银行敢不敢让Agent动态生成利率模块?第三,也是最棘手的,责任链会彻底断掉,以前出bug可以找程序员、找提交记录,以后Agent写Agent,代码自循环,谁来为故障买单?所以未来技术栈最难的坎儿可能不是“怎么让Agent写代码”,而是我们敢不敢让一个会犯错的系统,修改自己赖以运行的根基。

@彭鑫:其实就是在架构层做好智能(容忍不确定性)和可靠性(追求确定性)之间的平衡。限得太死“智能”没了,放的太开“靠谱”没了。

@彭鑫:@茹炳晟(腾讯) 后半截否定了自己的前半截 [憨笑]那你觉得合理的模式应该是什么?

@茹炳晟:没有否定,我感觉中期看还是“新三层”

@茹炳晟:我的观点是底层“干脏活累活”的还必须是确定性代码

@彭鑫:@茹炳晟(腾讯) 嗯,这是原子能力那部分。

除此之外,一些整体规则秩序的维护可能也需要以代码为主。

@沈欣:无论性能、功耗、确定性,都是确定性代码更胜一筹

王禹程:

未来技术栈会从“写功能”转向“编排行动”:除了模型层,更关键的是工具/数据连接协议、Agent 运行时(权限/沙箱/记忆)、多智能体编排、观测与治理。MCP 的意义在于把数据源与工具接入标准化,减少碎片化集成的胶水成本。 形态上我更看好“模型为规划与执行,代码/策略/测试为约束与验收”的共生体;像 Claude Code 的 Agent Teams 已把多实例并行协作编排成优先能力。

观点讨论

@肖然:今天马斯克的发布会还是挑战了这个“模型+代码”观点,喊出了26年底直出二进制了

@沈欣:马斯克有本事直接三进制,哈哈哈。

@王昊奋:简单来说,结构化工作流指令(Structured Workflow Instructions)不再是让 AI “凭感觉”写一段话,而是给它一套标准作业程序(SOP)。这套指令将复杂的业务场景拆解为可预测、可验证的逻辑步骤,是 Anthropic 在企业级应用(尤其是 Claude for Enterprise )的核心逻辑。

谢吉宝:

我的判断是两者都会有,但主流会是“模型+代码共生”,边界重新划分。

纯“模型操作数据”听起来很性感,简单或者非严谨场景也可行,但一到复杂业务就会遇到三件事:稳定性、合规性、成本。这三件事逼着我们必须保留大量代码和工程体系。

模型的优势在于“模糊处理”与“意图理解”,代码的优势在于“确定性”与“效率”。所以更现实的形态是:

● 模型负责理解、生成、决策的柔性部分,比如需求理解、信息抽取、推荐下一步、自动化编排

● 代码负责确定性、边界清晰、可验证的部分,比如权限、交易、账务、关键流程、SLA、审计

另外,我觉得未来的技术栈也会发生一些变化:

● 后端会出现一层新的“AI编排层”:Prompt/工具调用/记忆/评测/回放/兜底策略,会变成标准工程

● 数据栈更偏“面向模型的数据”:不仅是BI那种表,而是知识库、向量索引、语义层、数据血缘、可引用证据

● 研发流程会多一套“AgentOps”:离线评测、在线监控、质量回归、成本治理…

总之,未来不是“代码被替代”,而是代码的位置后移:更多变成“护栏”和“底座”。

观点讨论

@彭鑫:@谢吉宝 Qoder AgentOps非常重要,比目前以故障发现和定位为主要任务的的AIOps重要的多

@谢吉宝:是的,随着 Agent 的含量越来越高,这个越来越重要。如何做好护栏是我们一开始就要思考的。

Question 3

主持人:传统软件的“不可替代价值”究竟是什么?这一点对于2B(如以SaaS为代表的企业信息化系统)和2C(如个人手机和桌面助手)软件有什么不同?这些软件是否真的会随着大模型和Agent等AI技术及其应用的发展逐渐消亡?或者其中哪些部分会被AI吞噬,哪些部分将得以保留甚至加强?

王昊奋:

传统软件的核心价值在于其确定性,体现在下面3个方面。计算精度:1+1 在财务系统中必须永远等于 2,不能因为大模型的概率波动而变成 1.99;合规与溯源:软件通过硬编码的逻辑提供了“审计追踪”,谁在什么时候修改了数据是有据可查的,这在法律和金融层面是契约的基石;效率边界:对于大规模、高并发的结构化数据处理(如数据库查询),二进制代码的效率比大模型的推理开销低几个数量级。

传统软件的“不可替代价值”不会消失,但其角色将从“舞台主角”变为“数字底座”。将被 AI “吞噬”的部分包括:导航与菜单层等将消失,取而代之的是自然语言驱动的“即时响应”;原本用于连接不同系统的中间件、繁杂的 API 调用逻辑等胶水代码将由 AI 动态生成;简单的 IF-ELSE 判断逻辑将被大模型的动态规划取代。将被“保留甚至加强”的部分可以有:物理引擎、加密算法、专业绘图渲染内核等计算引擎,AI 会学习“如何使用”它们,而非“取代”它们;能够提供高质量结构化数据的 CRM 或 ERP 系统(甚至是标准化数据底座)不仅不会消失,反而会因为“好用”而变得更值钱。

过去的软件 = 界面 + 逻辑 + 数据。未来的软件 = 指令(AI)+ 执行器(代码)+ 知识(数据)。

观点讨论

@彭鑫:我觉得一部分流程应该会保持代码化,但这个代码有可能是在运行时由AI来主导进行动态调整(自适应)和版本演化(自演化)。因为这样执行起来更加高效和一致。这个可以类比我经常想的一个例子:一个餐厅开业后经过一段时间摸索一定会总结若干标准流程,例如客人进门后如何领座、点菜、上菜等,因为这样服务员们就不用动脑经去想了而且也不会犯错。但这个流程可能会每隔一段时间复盘总结后进行调整。

茹炳晟:

传统软件最值钱的那部分从来不是界面长啥样、菜单怎么排,而是它敢拍着胸脯跟你承诺“这事儿办成了”,比如企业发新系统误差不能超过一分钱,医院的HIS系统不能把药开错人,银行的核心交易系统哪怕断网也得保证借贷平衡。这种确定性不是靠聪明劲儿堆出来的,是靠几十年的流程固化、权限钳制、审计留痕,甚至是通过了无数轮合规审查和法院质证的。2B和2C在这里头分岔得很厉害:个人手机助手你猜错一次天气、推荐错一家餐厅,用户骂两句也就过去了,但SaaS系统要是把采购订单算错一位数、把审批流给跳过了,那是要赔钱、要上被告席的。所以2B软件真正的护城河根本不是功能多全、体验多顺,而是它长了一副“出了事能找到谁签字”的骨架。

那AI会把这些都吃掉吗?我觉得正好反过来,AI会逼着传统软件退回到它最擅长、也最枯燥的阵地。数据录入、报表生成、客服问答、界面导航这些“体力活”肯定被吞得干干净净,企业以后不会再花钱招聘一个“表单填写器“。但那些跟钱有关、跟责有关、跟法律效力有关的核心流程,反而会因为周围越来越智能而显得更加金贵。甚至会出现一种奇观:外围全是黑盒Agent在跑,进进出出热热闹闹,但到了最后那笔钱谁批、那张单子谁签,系统啪一下切回一个笨得要死的、写了二十年的COBOL模块,因为只有它出错了能找到人坐牢。所以消亡的不是传统软件,是传统软件里那些靠信息不对等收费的中间层。而留下来、甚至被加强的,是它作为商业社会底层契约承载者的身份。这个身份AI永远学不会。

从架构视角往下挖一层,传统软件最不可替代的价值其实藏在那个被无数人嫌弃的“分层”本身,不是因为分层设计有多优雅,而是每一层都是一道责任防火墙。数据库层保证存进去的数字取出来不会自己加一,应用层保证业务流程不会被跳号,界面层再烂也就是难看了点,捅不穿底层的借贷平衡。这种“层与层之间的笨拙隔离”,才是商业软件敢上生产环境的底气。现在Agent来了,最大的麻烦是它天然是个打穿各层的刺头。它为了完成一个任务,既想读数据库,又想改业务规则,还要模拟界面操作,在三层之间来回蹦跶。短期看确实效率高,长期看等于把花了三十年砌好的防火隔离墙凿成了开放式工位,一旦Agent误判,造成的破坏不再是界面卡死这种皮外伤,而是数据污染、逻辑错乱、审计断链这种内出血。

观点讨论

@王楠:我认为对已有传统软件是个中短期的过渡,面向agent的软件会兴起,传统软件中拆分出的原子功能片段(AK称之为细菌代码)有长期存在的价值。传统软件中可复用的细菌代码成为关键资产。将AI agent的敏捷性与SaaS的可靠性结合”的企业是稀缺的——SaaS提供工作流、治理和护栏,AI agent扩展生产力和速度。长期看,agent都会重写已有的软件

@茹炳晟:新兴的业务我觉得完全有可能,但是对一十几年的老系统,我觉得比较难。

@茹炳晟:所以未来架构上会倒逼出一种”反向重构“:不是Agent吞噬分层,而是分层为了驯服Agent而变得更森严(把Agent关在笼子里,在笼子里你可以任意自由发挥)。界面层会大面积腐烂,因为用户不点了,但这层会进化出意图护栏,专门负责拦截Agent的不合理指令。逻辑层会分裂成两块,一块是可变逻辑,跑Agent动态生成的代码,快速迭代;另一块是固化策略沙箱,跑那些“动一下就可能坐牢”的业务规则,只读不改,Agent碰都别想碰。数据层则会更保守,ACID事务、操作日志、快照回滚这些老掉牙的功能反而会成为Agent时代的奢侈品,以后拼的不是谁能更快写数据,而是谁能在Agent乱写之后还能把数据洗回来。

@彭鑫:@茹炳晟(腾讯) 有道理。现在很多企业员工岗位是在处理1)不同的孤岛系统之间的联系,例如手工根据一个系统的输出表格录入另一个系统;2)处理非标准业务,例如通过线下会议等方式。

业务软件中GUI不会完全消失,因为还要保留一个面向人类员工的“手动模式”,也就是说最坏情况下人类员工可以用键盘鼠标接管Agent干的活。

@茹炳晟:最差情况下的HITL[机智]

@彭鑫:@茹炳晟(腾讯) 而且这种分层责任分担也是社会化的,例如数据库厂商确保数据库读写的可靠性,企业内不同岗位的员工确保不同部分的业务可靠性。

现在混为一团Agent化之后,责任其实也不清楚了。这也要求Agent化之后倒过来在一些关键环节上配人去重建这套分层的责任分担体系。

@王昊奋:分类、分层、分级,一直是很有效的围栏和专项专办的手段

@彭鑫:@茹炳晟(腾讯) 我觉得还有一个可能的趋势是企业管理体系会进一步软件化,进入软件世界来分层管控Agent。这也很好理解,以前企业管理制度管人类员工,现在要把数字员工(Agent)也管起来了。

@沈欣:数字主管[呲牙]

@王昊奋:软件定义的业务数字孪生,推动管理精化和组织变革

@肖然:这个已经是Palantir的卖点了

@王昊奋:@肖然 Inspire 对,所以这块是值得借鉴的

@茹炳晟:感觉某天会不会出现”我的老板是机器人“,这个梗来自”我的女朋友是机器人“[坏笑]

@彭鑫:@茹炳晟(腾讯) 完全有可能。前几天不是有报道说AI开始给人类发众包任务了嘛,这个其实也很自然。

@茹炳晟:补充一个点,传统软件经常被骂死板、不智能,但这恰恰是它的防御姿态。一个设计良好的核心系统,对新需求的态度天生是拒绝的。你要加个字段?先走三个月的合规评审。你要开个接口?先证明所有异常路径都有回滚。这种“难用”不是技术落后,是故意的——它在用程序的低效率,对冲toB业务的高风险。Agent太灵活了,见人说人话见鬼说鬼话,反而容易在合规的灰色地带滑出去。

@彭鑫:@茹炳晟(腾讯) 是的。所以我听说以前软件项目中有些可能有一些难以开口的需求就是能否留个灵活处理的后门,否则都被软件限死了。 [憨笑]

观点讨论

@彭鑫:我觉得传统软件的一致性和确定性是很重好的。虽然代码一般人不一定看得懂,但专业工程师能看懂。代码中编码了大家达成共识的处理流程和规则,一般就会以一致和确定性的方式去执行。这个对于人类社会很多时候是很重要的,否则我们就要忍受一种“神秘力量”来掌控系统运转,遇到不公众的情况只能抱怨运气不好(AI临时性脑子短路了)。

@赵俊民:agent应用软件是传统软件的扩展,以前通过确定性编程无法很好处理的场景,现在ai有了多模态处理,规划,推理能力。传统软件我理解大部分都会保留下来,因为很多已经非常高效

@肖然:我觉得传统软件对比ML和LLM最大不可替代就是“流程”

@谢吉宝:+1,本质就是确定性,尤其 2B,要责任链。

@赵俊民:对于那些说替代,消除的逻辑,我觉得大部分都是低估了人类长时间积累的业务积累

@谢吉宝:赞同,这个和能搞定双十一确实搞不定 12306逻辑差不多。双十一可以为体验体验做各种优化,12306 要考虑得更多…复杂度不在软件本身。

@赵俊民:一个按钮点击,比说一堆话那个效率更高值得讨论

@谢吉宝:这个我觉得倒也还好,类似 A2UI 也可以高效。

毛剑:

2C 事实上99.9%的网站已经消失了,网站也好,app也好,作用是帮人类“归类”。

就是一种聚合需求的工作模式,现在AI能更好的完成这个作用。我认为娱乐软件不会消失,哈哈哈。

2B本质上在我看来是业务流转的流程系统,核心价值实际是围绕流程+数据的集合,而大模型可以比较好的解决流程的编排规划问题。

观点讨论

@彭鑫:@浪客剑心 2C的APP我觉得有很大一部分核心价值是背后的资源渠道,例如大众点评和携程的价值在于他们联系的这些餐厅和酒店资源。

@毛剑:对的,这样就变成了纯API,线上到线下的转换,而模型可以驱动端到端解决问题,App我理解会消失,能力不会,可能是API First-Class

@茹炳晟:API契约会取代界面,成为新的刚性边界。以前传统软件对外是黑盒,你点按钮我给你结果;未来传统软件对内也成了黑盒,Agent从业务层调用,系统只认经过审批的API签名,不认任何花言巧语。这叫以静制动,你Agent再聪明、再能说会道,到了核心账务系统的门口,对不起,只读接口,密码在保险柜里,钥匙归合规部管。

沈欣:

传统软件目标:准确、快速、安全。

缺点:灵活、成本、开发效率

2B和2C

2B——高频次使用,极致的准确度要求,生产力工具

2C——易用,一站式,方便与隐私间的平衡

只有工程化的手段才能解决问题, AI天生自带的幻觉,无法消除,不可消除。

传统软件从某种意义上来说,是一种工程化的极致,他的确定性是靠这么多年工程化的积累来保障的。

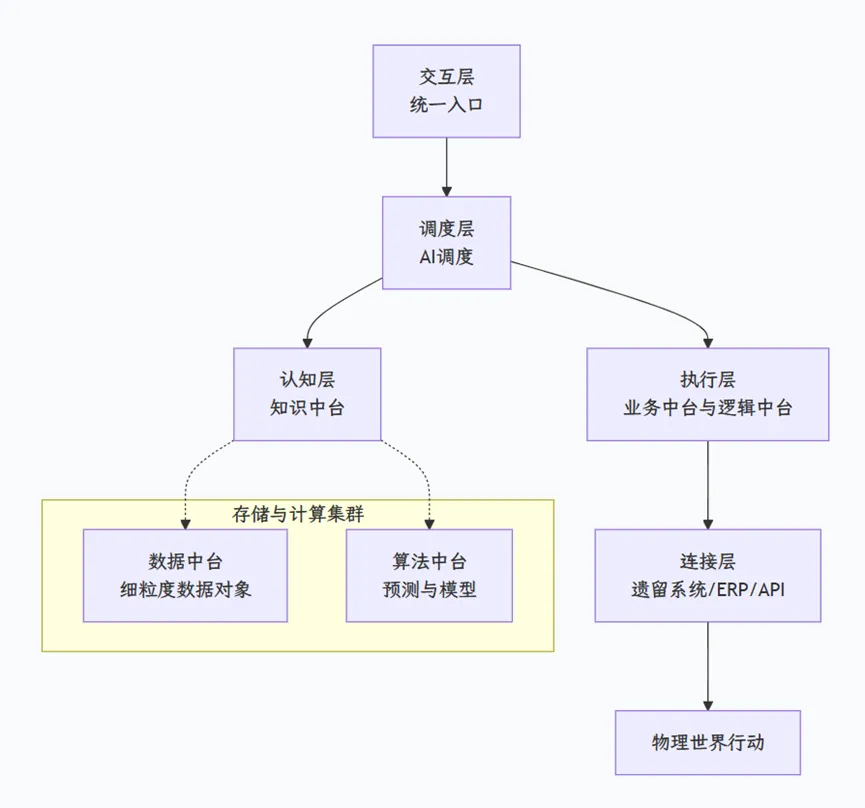

第一层:调度层

这是大脑皮层,唯一面向用户/外部请求的入口。

第二层:认知层

这是区别于传统数据中台的数智库的核心。

第三层:执行层

这一层是架构中确定性的代表。AI在这里没有“幻觉”,只有精确计算。

第四层:存储与计算集群

这一层不直接对AI提供服务,而是对认知层和执行层提供能力支撑。

第五层:连接层

连接真实世界

这是我设想的混合结构。如果将模型与传统代码放在一起,低代码是非常好的桥梁。

王楠:

“确定性系统”vs”概率性系统”的二分法将决定SaaS能否被AI替代的关键不是品牌或数据,而是其核心系统是确定性的还是概率性的。确定性系统(如ERP、财务、合规)要求100%一致性,LLM的概率性本质无法替代。而概率性系统(如营销内容生成、客服一线响应)正在被AI快速吞噬。这意味着”不可替代价值”可能在于业务场景对确定性的要求程度。在确定性系统中,企业数据接入Agent,现有软件接入agent都需要传统软件支持。现有的方案是三层栈:底层是传统软件,中间是agent操作系统,顶层是agent生成的结果界面。传统软件是整个系统的地基。我有一个暴论,传统软件使用量在未来很长一段时间可能反而增加。例如,一个营销人员以前发有限的外联请求,现在AI agent瞬间将量翻三倍,反而需要更强大的CRM来管理涌入的响应。类似的事情在搜索领域已经在发生。

观点讨论

@赵俊民:重写现有软件价值是什么?

@沈欣:可以适配新的,自动迭代的业务模型,AI没有确定性,AI生产的代码可以有确定性

@王楠:我的看法是其实很多功能对具体的用户来说是没有价值的,有价值的地方可能处于其他考虑也不是最优的实现。

@谢吉宝:我反而觉得低代码意义不大,重写比重构容易。直接设好护栏,定好规则,重写就可以了。

@沈欣:微调呢?小迭代呢?

@赵俊民:我觉得总要找到真正价值,重构现有软件不知道有什么刚性需求,当然新的业务需求,可能会考虑ai First

@沈欣:@谢吉宝 Qoder 我举个例子,企业在发展,一个零售商,一家店的时候,老板资金有限,所以在订单审核的时候,要考虑现金流压力,审核要检查总订单的金额是不是在可控范围内,过了段时间,开了5家店了,有库存积压问题,所以订单审核需要考虑订货总量的可销天数,再过一段时间,开了20家店了,订货需要考虑不能向小供应商订货,审核要控制小供应商的订货额,再过一段时间,100家店了,要做价格带管理了,就要考虑偏离价格带的商品订货数量要被控制,再后来到了年底,要考虑供应商的返点,所以年底的订货额要考虑是否满足返点的要求,应该稍微多定一点,这些全都是——“大部分“中台”的失败,源于试图在业务逻辑仍未稳定时,过早地将其抽象和固化。”这句话背后的意义。

传统的业务中台没有这么灵活,都是细颗粒度的,而低代码平台可以存放这种变化的,差异化的业务逻辑。

每次都重构代码?

@赵俊民:点个外卖,通过app还是agent有啥区别,看不懂

@肖然:重构现在软件关键是经济帐,当然还有全球竞争因素,工业界看跟技术关系不大

@肖然:比如咱们下主机这么多年了,现在西方才开始

@王楠:感觉执行层和认知层可能需要一个连接,执行代码需要的context一部分会来自于认知层,另外执行的原始结果是否也应该在认知层存储

@朱征宇:是的,跟技术关系不大

@茹炳晟:商业的入口变了,谁掌握入口谁就有话语权

@赵俊民:是,可能大家都在卷ai,但是对用户不知道有啥好处,以前点个按钮,现在通过各个app 提供的agent,还是在自己生态玩。如果是用户获得最优解,有价值,现在感觉完全变味了,还是那些自己生态圈子

@沈欣:@王楠 我也想过这个问题,后来觉得上面的一层AI调度应该能够成长起来[呲牙]

@谢吉宝:我是觉得所有“低代码”的地方都可以用“spec”来表达,然后AI 来实现,所以“低代码”存在的必要性不大了。

@沈欣:实时生成代码?

@茹炳晟:“低代码”的确定性可能是关键

@谢吉宝:不是实时,是写的“低代码”就不用了,用 ai 生成就行了。低代码就是想快,本质还是代码,只在一些流程上抽象了一些组件。但这些 ai 非常擅长,所以我想说“低代码”这个产品形态可能不需要了。

@沈欣:低代码完成确定性的工程化框架,里面由AI根据SPEC来填充。就像钢筋和混凝土的关系

@谢吉宝:@茹炳晟 人和 AI 形成默契后,spec 现在也可以很确定了

@茹炳晟:spec确定没有问题,但是从spec到代码如果用现有的LLM,依然是概率属性

@谢吉宝:以我的实践来看,进步很大了。这就好比为什么有二进制还要有高级语言,为什么 python 易读,spec 就是更易读的语言,llm 是翻译。

@赵俊民:spec这种折中的让步不看好,不伦不类

@朱征宇:低代码很像Mark down,可以一层套一层

@沈欣:现有的低代码平台,要是不能兼容AI自动填充,那就没必要存在了,当然,那个时候可能不叫低代码了

@赵俊民:人太懒了,写一堆人看不懂或者想要ai看懂东西,获得还是一堆无法保障质量软件,最终还是被舍弃。未来要不ai大模型够强,要不未来编程语言自身够强,才是未来

@茹炳晟:假定现在准确率95%,将来99%,只要不能达到100%,后面的1%依然需要很多工作量。那为何不一开始就用100%确定的低代码

@彭鑫:那就很麻烦,少的那1%或者画蛇添足的那1%搞不好就会成为灾难,而人类要去兜底确认的前提是自己能搞懂整套系统

朱征宇:

AI不会取代软件公司,AI会取代跟不上时代的软件公司。一个领先的2B软件公司的立足之本是专业信用和兜底的责任。无论采用哪种技术,软件公司需要确保提供安全、合规、可靠、好用的IT服务。

观点讨论

@茹炳晟:作为看着ServiceNow一步一步长大的我来说,太同意了

@彭鑫:@王昊奋 OpenClaw这种过于主动的做法是否有严重的副作用?抛开安全风险不谈,它如何识别用户IM信息中哪些是希望Agent去干的哪些是闲聊甚至发牢骚?

@王昊奋:简单来说,结构化工作流指令(Structured Workflow Instructions)不再是让 AI “凭感觉”写一段话,而是给它一套标准作业程序(SOP)。这套指令将复杂的业务场景拆解为可预测、可验证的逻辑步骤,是 Anthropic 在企业级应用(尤其是 Claude for Enterprise )的核心逻辑。

王禹程:

传统软件最不可替代的,是可信记录(System of Record)与确定性责任链(权限、审计、合规、交易一致性)。Agent 会优先吞噬“纯 UI + 流程搬运”的包装器;但会强化数据治理、身份权限、审计、计费与 API 的价值。OpenClaw 的安全风波提示我们:当软件能直接读写文件、执行脚本时,真正的护城河是“可控权限 + 可追溯执行”。 2B更看重合规与可控,2C更看重隐私、端侧体验与信任。当然,不同culture settings也会有差异。

传统软件的“不可替代价值”可以归结为两个核心:记录的真实性(System of Record)与逻辑的确定性(Deterministic Logic)。

将被 AI “吞噬”的部分:

1. 工作流包装器(Workflow Wrappers):如果一个软件的价值仅仅是给大模型加了个UI、或者仅仅是简单的表单填写和流程中转,那么它极易被像 Claude Cowork 这样的插件或 OpenClaw 这样的本地代理直接取代。

2. 初级知识劳动力界面:大量用于数据录入、初级文档起草、简单的工单处理界面将消失。UI将变得“隐形”,用户通过自然语言直接调用后台能力。

3. 中间商加价(Middleman Markup):那些仅仅靠调用 API 并在其上叠加简单功能的“包装公司”将失去生存空间 。

将被保留甚至加强的部分:

1. 底层基础设施与数据平台:随着AI对干净、结构化、可观测数据的需求激增,拥有强大数据治理能力和统一数据湖架构的平台(如 Databricks, Snowflake)地位将大幅提升。

2. 治理、审计与合规层(Orchestration & Governance):AI代理越是自主,企业就越需要“治理即代码”(Governance as Code)来监控、限制和审计这些非人类实体的每一个决策。

3. 系统架构与战略设计:软件开发的价值向“系统架构设计”和“问题拆解”迁移。人类的角色从“编写者”转变为“评估者”和“导演”,专注于定义“为什么做”而非“怎么做”。

软件不会消亡,但其“形态”会发生剧变。未来的成功者是那些能够将自身的确定性数据底座与AI的生成性执行能力无缝整合的“代理原生”(Agent-Native)企业。传统软件将退居幕后成为稳健的“脊椎”,而AI代理将成为敏捷的“肌肉”和“五感”。

谢吉宝:

我觉得传统软件是不可替代的,原因如下:

● 确定性:结果稳定、可验、可复现

● 信任结构:权限、审计、合规、责任边界

● 工程效率:性能、成本、可维护性、可运营

2B vs 2C的差别

● 2B更在乎“责任链”:错一次可能就是事故,所以更需要流程固化、权限隔离、审计记录。AI能加速,但很难“全自动放权”

● 2C更在乎“爽感和效率”:容错高,能带来“少点几下”的体验就赢,所以AI吞噬界面和交互会更快

至于会不会消亡?我倾向于说:不会消亡,但会重排版图。很多软件会“看起来像消失了”,因为入口变成对话/Agent,但底层系统反而更重要,比如千问能买奶茶,入口变了,但底层还是交易和支付。

以后这种信息密集、规则不硬、以检索/整理为主的功能,比如搜索、客服、报表解读、文档写作、会议纪要、简单数据分析都可能会被 AI 吞噬。同时“中间层界面”会被削薄:很多表单式操作,会变成“说一句话+确认”。

但以下这些场景我觉得仍然会保留甚至加强:

● 核心交易/核心账务/主数据:这类必须确定性、可审计

● 系统集成与数据治理能力:AI越多,数据越乱,治理越值钱

● 安全与权限体系:尤其2B,AI引入的新风险会让这块更重要

Question 4

主持人:大模型与Agent在2B和2C软件中的广泛应用将带来什么样的风险和挑战?为此需要加强哪些方面的技术研究和实践探索?

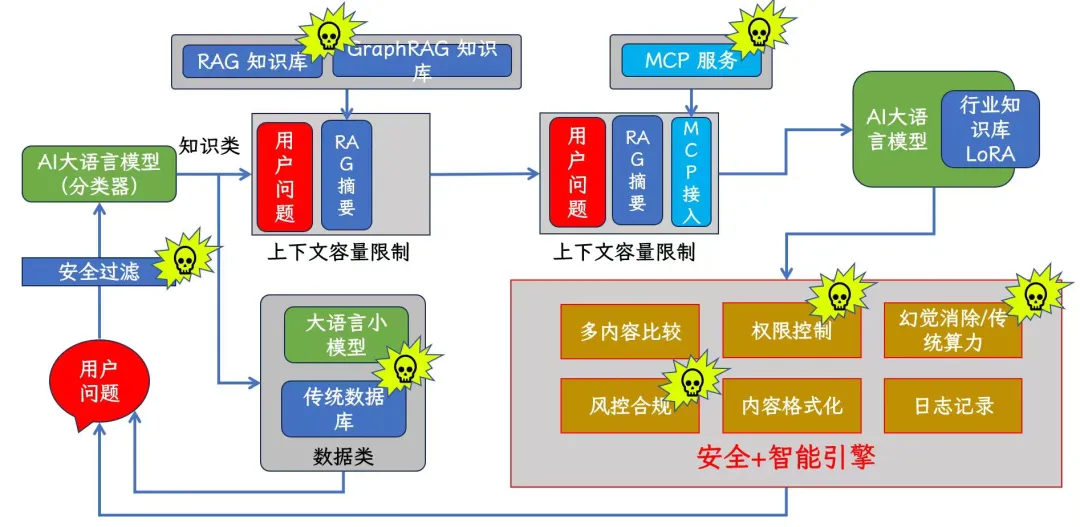

王昊奋:

对于企业而言,Agent 的核心挑战在于如何将概率性的模型塞进确定性的业务流中。大模型的概率性本质与企业财务、合规等硬性逻辑天然冲突,极易引发幻觉导致的业务崩塌、权限越界及提示词注入风险。2C 的焦点在于 AI 如何深度介入个人生活,以及由此产生的边界模糊。这样则面临隐私主权彻底让渡、长效记忆被恶意“下毒”操控以及自主决策引发的问责黑洞。无论是2B还是2C,当软件从“被动工具”进化为“主动代理”,风险也从单纯的系统崩溃演变为深层的逻辑欺骗与认知失控。

未来的研究重心理应从“追求模型规模”转向“构建可信执行底座”。技术上需要参考Palantir深化以知识图谱为核心的 KAG(知识增强生成) 架构,利用结构化逻辑锚定事实以消除幻觉;工程上需研发针对 Agent 的“零信任”沙盒执行环境与动态权限网格,确保其“行动权”在受控范围内;评测上则需建立全链路可观测的 Agentic CI/CD 范式,实现对 Agent 推理轨迹的实时审计与拦截,将 AI 的灵活性锁在工程的可靠性之内。

毛剑:

1,我们自己也有开发2C的Agent产品,最大的挑战在于passk问题,模型具有不确定性,会失败,如何纠错完成任务非常的关键。

2,Agentic RL 对于复杂Agent执行也是近期我重点关注的,尽可能去优化任务的成功率。

3,另外风险性问题Human in the Loop 需要认真思考,模型的权限有多大,哪些需要审计和审批,我认为安全问题要重视。

肖然:

我想风险2B主要是安全与数据泄露,但2C感觉更麻烦涉及隐私和伦理。虽然大家觉得2C更好推广,但我觉得风险更大。可以参考最近澳大利亚和欧洲对于16岁以下的社交媒体限制。这个就是互联网,特别是短视频带来的问题。

观点讨论

@谢吉宝:2C 的在移动互联网时代就已经泄露的差不多了[捂脸]

沈欣:

我觉得软件也有 ”恐怖谷效应“:AI无法达到6西格玛准确度,但是又在测试环境表现良好的时候,是灾难的开始。

现在AI已经可以做部分可控制的自动化,技术都齐备,最缺少的是泛用方法论。

工业皇冠顶上的明珠——航空发动机,光刻机

数学皇冠顶上的明珠——哥德巴赫猜想和孪生素数猜想

物理皇冠顶上的明珠——统一场

软件开发皇冠顶上的明珠:请帮我按照SAP的说明书开发一套企业ERP,功能界面都要求一致

观点讨论

@沈欣:我觉得现在最大短板就是工程化,刚好这个是中国人相对擅长的,另外安全也是大问题,仅仅是一个基础互动,全是高风险点。。。。

@肖然:RAG和LoRA其实应该考虑是不是好的方向了,这两个做法其实放大了风险。

@沈欣:上次有个很有意思的案例,训练RAG的时候,有了某人的名字,后来这个人出事了,这个名字怎么也删不掉,哈哈

@王昊奋:RAG本身会被Agent吃掉,同时核心在于库的建设。而LORA则是一个对未知任务或数据指令与现有能力(通用)之间的tradeoff。都有side effect

@茹炳晟:LLM本身也有这个问题,RAG还好处理

@沈欣:GraphyRAG就很麻烦了[呲牙]

茹炳晟:

其实最让人不安的不是技术失效(失效顶多就是点不了奶茶),而是它明明在运行,你却不知道它在替谁做主、如何得出这个结论,出了问题该找谁。2B这边最大的坑是责任漂移:以前SaaS系统的逻辑是写死的,合规审查、财务审计、业务风控都能溯源;现在Agent自主动态规划并调用工具、甚至动态生成代码,一个越权操作发生了,是骂模型、骂集成商、还是骂那个没在五分钟内介入的业务主管?法律上根本没有“半自主决策者”这个责任主体。2C那边更隐蔽,风险不在明处的隐私泄露,而在信任幻觉。当你习惯让Agent替你读屏幕、填表单、回消息,你其实是在用一次次的模糊授权,把数字生活的决策外包给一个你并不真正理解的黑箱。

观点讨论

@彭鑫:还有个问题是整个系统的运转不像以前有明确的分层模块化结构,局部出了问题还可以通过信息隐藏和抽象机制在局部解决而不影响其他部分。所以不看好靠强化学习算法确保Agent长程任务执行的可靠性,因为缺少与传统的分层模块化和抽象与信息隐藏这样的方法论支持。

@肖然:本质上可能软件工程要接受从 离散数学到概率信息论的转变

@彭鑫:@茹炳晟(腾讯) 确实,自主的Agent可能会动态生成一套很复杂的责任委托链,比如派生SubAgent、生成代码,然后又派生又生成,兜了一圈又一圈。我甚至怀疑以后AI有时候会故意把这个责任委托链搞的巨复杂从而使得人类事后很难审计发现问题。

就像人类社会经常也会发生类似的事情。

@茹炳晟:所以我觉得Agent后续的一个重要命题之一是“完全可追溯的行为审计”,行为审计要重新发明,传统日志记“谁在什么时候调了什么API”,未来得记模型当时的思维链指纹、置信度、备选方案,让每一次自主决策都可复现、可质询。

@彭鑫:嗯,这是很重要的新研究方向,而且感觉要深度融合管理学理论和实践

@朱征宇:审计要进入神经网络内部,否则只能在外围打转转

@王昊奋:已经在做了,最近会有不错的工具让大家用用,:)

@茹炳晟:@彭鑫 是的,包括社会学都应该会包含。

@茹炳晟:审计要进入神经网络内部,应该挺难实现的

@沈欣:为啥老是想让LLM干他不擅长的,为啥不是他去做更擅长的,分工很重要啊

@沈欣:这是死胡同,没意义,好像政审就能保障这个人一定没问题一个逻辑

@肖然:是这个观点,但现在今天主要还是探讨是否LLM能够把传统软件给吃掉

@沈欣:我觉得各司其职,互相协助,1+1>2就好,没必要二元论一个死一个活嘛

@彭鑫:@朱征宇 这个我不是太同意,应该不需要进入神经网络内部,而是通过流程设计把Agent与人混合的流程环节梳理清楚,在原子任务之上进行审计。例如某处模型推理需要记录和审计的是模型的输入和输出等。

@赵俊民:我的观点是不会,并且看不懂商业逻辑

@肖然:按照马斯克的理念,答案就是肯定的,我直接LLM做二进制了,传统软件的code-compile模式将没有意义

@茹炳晟:同意你说的,LLM就该干他擅长的,不擅长的留给专业的确定性方法

@彭鑫:就像企业管理重点是从流程上来确保质量和可靠性,甚至流程设计从一开始就要假设人是会犯错误的。@肖然:对,流程驱动 vs 数据驱动一直是企业管理中找平衡的点

@赵俊民:新的业务需求ai first也要看是什么场景,确定性软件做的很好为啥要每次靠花钱token去做。

@王昊奋:其实技术演进的浪潮中,当红辣子鸡总是希望扩大自己的地盘,所以就变成无论擅长不擅长都一股脑进入自己的管辖范围,不过随时时间推移会发先消化不了或直接就无福消受,所以就会产生各司其职,各种冷静的思考

@王楠:非常同意,按照“漏斗-喇叭”模型,真正能通过产业漏斗的才是实际有用的部分。现在agent落地除了coding,其他还在漏斗阶段

@赵俊民:现在是技术发展期,确实大家比较热,适合不适合都想要用,最终过几年就是冷静冷静

@肖然:热潮还需要1-2年昵,冷静估计3年后

@朱征宇:gartner曲线

@王昊奋:其实无所谓冷静与否,大家自己根据因为相信所以看见往前走即可,大家都冷静了,就不会有百家争鸣,都趋同了,多没有意思呀

@肖然:这波感觉都不是泡沫了,是大家都得梭哈,Salesforce这样的昔日SaaS王者也梭哈了

@赵俊民:任何底层逻辑还是商业逻辑,到底解决核心问题是什么,技术大发展是好事,扩大了软件处理现实问题边界也是好事

@王昊奋:泡沫肯定有,但是不那么大,持续有东西可以撑住场子就会持续,就值得梭哈

@肖然:商业逻辑之外,还有竞争了,Grok进Dpt of War了

茹炳晟:

更长远看,toC和toB都会遭遇同一个瓶颈:依赖云端大模型的系统越聪明,断网时就越像个傻子,这种数字依赖的脆弱性在工业控制、医疗、金融等关键领域是致命的。所以技术研究的重心必须从让模型更强大转向让失控更优雅。

一是可干预架构,不是追求模型永不犯错,而是设计“人在回路的高效介入点”。不是追求99.9%的正确率,而是设计轻量级的决策拦截点,让用户在自然语言界面里就能说“等等,这个单子别发”。

二是2B场景需要“数据不动模型动”——将模型压缩后下沉到客户私有环境,或通过联邦学习让模型适配企业数据而不带走数据。

三是轻量化本地内核,为关键业务保留一个断网也能跑的规则沙箱,哪怕功能只剩20%,至少不出大错。

四是行为审计要重新发明,传统日志记“谁在什么时候调了什么API”,未来得记模型当时的思维链指纹、置信度、备选方案,让每一次自主决策都可复现、可质询。

最难的其实是最后一件事:我们缺一套给Agent用的“价值观规则”——不是技术标准,而是像人类社会的红绿灯、路权、责任认定那样的价值行为契约。这事光靠工程师写不出来,就算写出来也变形了。

观点讨论

@肖然:这个也不一定,现在开始流行的“养虾”年轻一代,买mac mini就是为了跑本地模型

@王昊奋:不至于像傻子,目前端侧和云端的差距会是拉大还是缩小还不是一个定论

@肖然:同意,虽然scaling law还没有失效,但确实OS方向进展很快

@王昊奋:简单来说,结构化工作流指令(Structured Workflow Instructions)按照Dense Scaling Law,其实云端越强,通过蒸馏等各种手段,端侧也一定会变得更强不再是让 AI “凭感觉”写一段话,而是给它一套标准作业程序(SOP)。这套指令将复杂的业务场景拆解为可预测、可验证的逻辑步骤,是 Anthropic 在企业级应用(尤其是 Claude for Enterprise )的核心逻辑。

@朱征宇:云侧是老师大模型,端侧是学生小模型

@沈欣:这不就是阿西莫夫的三定律,所有机器人必须第一优先学习进去

@茹炳晟:@王昊奋 这个有道理,架构上需要有断网后的本地降级机制

王楠:

我的直观感受是:AI 终于从“聊天框里的智者”变成了“桌面上的打工人”。Cowork和OpenClaw的表现把“Agentic Workflow”彻底工程化了。

Anthropic 并没有为每个行业建立复杂的专有模型,而是通过“结构化工作流指令”将 Claude 的泛化能力锚定在特定场景,实现了从 API 逻辑转向业务逻辑的设计突破。此外,Claude Cowork 实现了在本地或隔离环境下的代码与数据处理。这种“数据在本地流转、逻辑在云端生成”的模式,解决了企业级应用最头疼的隐私与安全合规问题。

OpenClaw则代表着极致的“本地主权”与“主动性”,一改传统 AI 的“拨一下动一下”,通过主动轮询机制,在后台监测邮箱、GitHub 或日程,并在检测到关键触发点时主动采取行动;深度集成了 Anthropic 的 Computer Use 能力,这意味着它不再依赖厂商是否开放了 API;同时以 IM 为终端,直接桥接到 WhatsApp、Telegram 或 Slack,直接诠释了最好的 UI 就是没有新 UI。

朱征宇:

当 Agent 拥有了感知和行动能力,风险将从数字世界跑到物理世界。对此,模型定位成“建议者”,关键决策和高风险操作要经过人工授权,确保人在环中(Human-in-the-loop)和安全护栏;针对具身智能,要在协议层嵌入物理安全指令,规范 Agent 间的通信机制,防止恶性协同。现在各家AI厂商在性能/功能快速迭代的压力下,放松了对于安全护栏的建设,是最大的伦理安全风险。如果不在基础层面植入安全伦理规范,一旦AI突破了某个临界点(好比”流浪地球”里,一旦进入洛希极限,物体就无法逃脱了),完全自我迭代,有可能安全失控。

王禹程:

大模型与智能代理(Agent)的崛起,不仅是效率的跃迁,更是安全、伦理与治理维度的“潘多拉魔盒”。在2026年,随着其在2B和2C领域的全面渗透,我们面临的挑战已经从“模型会不会说错话”演变为“代理会不会做错事”。如何构建可信的技术栈是急需要突破的。

Question 5

主持人:您如何看待未来五到十年软件领域的智能化变革?中国软件产业和广大软件工程师应当如何迎接这场变革?

王昊奋:

对于软件变革,那篇文章已经有充分讨论,我这里再复述一下。软件将完成从“静态代码组合”到“动态推理实体”的本质进化。传统以 GUI(图形界面)和硬编码逻辑为核心的架构将解构,取而代之的是以模型为推理中枢、代码为执行工具、知识为逻辑锚点的 Agentic 架构。软件不再是被动等待指令的工具,而是能够自主拆解任务、调度插件并交付结果的主动代理,其核心价值将从“实现功能”迁移到“达成目标”。

我认为中国软件业的突围路径在于利用深厚的行业壁垒,实现从通用大模型向“垂直领域专家智能体”的纵深发展,将行业专有知识图谱与大模型深度对齐,解决AI在2B 场景下的幻觉与合规痛点,是构建核心竞争力的关键。产业重心应从单纯的App 开发转向构建“高可靠、可审计”的数字员工生态,将中国海量的场景经验转化为可编程、可流转的智能资产。

软件工程师的角色将经历从Implementer(实现者)到Auditor(审计员)与Orchestrator(编排者)的身份重构。在 AI 能够高效生成基础代码的背景下,核心竞争力将缩减为“定义问题的深度”与“系统架构的抽象能力”。工程师需要掌握如何通过严密的Spec(规范)驱动模型,管理长效记忆与工具链协同。甚至掌握“一人公司”(One Person Company,OPC)思维,利用 AI 代理集群实现个人效能的指数级释放,将成为这一代开发者的新标准。

毛剑:

5-10年太难预估了,现在最大的感触是每天都在变化,我记得看流浪地球就是moss操作生成了一个系统,和Claude Code目前的模式完全一致,我坚定的认为就是这一条道路。模型思考,代码(工具)执行。

与其等待观望不如从现在开始主动变革,把能自动化执行的都开始如何最懒的方式来重塑自己的日常工作,比如开发、测试、文档等,被时代毒打改造还是主动改变变革很明显。构建自己的个人助理,把过去的工作改成面向AI友好,长期考虑AI做你的工作,你来思考学习如何提问,提出问题更重要。

观点讨论

@赵俊民:为啥code agent最早商用,为啥还要生成编程语言的确定性软件,为啥不能直接去干活

@彭鑫:因为有人确认兜底负责,而且不是对某一次任务处理负责,而是对一类任务的处理方式负责

@沈欣:我们企业每天15万笔POS交易,用AI直接做?估计挣的钱刚好付Token费用[呲牙]

@肖然:那你们可以看看stripe,AI带来新增值服务;)

@沈欣:对大量国内的现有企业不太现实。

@肖然:确实资本投入是个限制,不过我觉得咱们走出去竞争是必然的。

肖然:

我觉得未来一波浪潮,要多思考元模型变化,Antrophic之所以最近爆发也是其从MCP、skills到Cowork的一系列工程元模型的定义和落地。我们如果不能在元模型上构建自己的体系,其实就还是只能跟随。

观点讨论

@王昊奋:要从这个看到危机感,AI企业因为没有来得及等到SE的协同,所以只能自己造轮子了。但是本质就是抽象,模块化,和各种流程调用,这些本该是SE的地盘

@肖然:咱们社会过于务实,所以大家直接上来就是卷,反而耽误了考虑本质变化

@朱征宇:是的,技术会演进,但是设计永远需要考虑可靠性、性能、质量、安全、合规、可观测性、可维护性等基本准则。手写的代码可能越来越少,但是系统思考只会越来越多。越是依赖 AI,越要具备“一眼看穿本质”的能力。

@王昊奋:需要一些度过温饱的率先来做避免不必要的卷

@赵俊民:这个核心是ai写的代码,怎么方法让他有可靠性,性能,质量,安全等?

@赵俊民:代码目前是软件最终呈现方式,怎么能让AI理解并构造一个结构,让其有这些质量属性,我一直没想明白

@沈欣:文档驱动开发嘛[呲牙]AI在低代码平台上写代码,代码就像钢筋水泥里的水泥,被限制在一个范围,从而带来确定性

@彭鑫:挺难的。人类是带着高度的责任心(间接来自于个人和家庭的重担)不断打磨,跟复杂系统死磕,最后才能换来一个足够可靠和高质量的系统。AI没有这个源动力,复杂系统理解又不行。

@肖然:过往系统,类似ERP,大量复杂业务流程逻辑,主要问题就是在于我们人类也难于梳理清楚来告诉LLM。

@朱征宇:需求是迭代出来的,质量也是迭代出来的,不是代码带来的,可以参考一下控制论,进行闭环迭代

@彭鑫:@朱征宇 流程院 控制论的前提是被控制对象符合基本物理规律,例如控制的连续性等,但如果把AI作为控制对象这个前提很可能就不满足

@肖然:我观点还是LLM为代表的智能体未来不会走流程驱动了,更多是数据驱动。所以本质上让LLM去给咱们搞一个流程驱动的ERP意义不大。

@朱征宇:AI不作为控制对象,而是作为控制工具

@王楠:除了责任,另一个角度是利益。作为一个熟悉业务的高级员工,把业务逻辑都讲清楚,之后由agent去运行后,员工的是否还能从agent产出的结果中受益,或者说agent的收益应该有谁拿走。

@朱征宇:AI启发,机理模型迭代,物理世界闭环

@朱征宇:所以,物理世界永远是检验真理的唯一标准

@肖然:我们人类走到工业革命的今天,流程的认知确实是智慧的结晶。但AI没有咱们这样的智力瓶颈,不需要我们这样的专业细分,也就没有太大必要强流程了。

@彭鑫:我觉得主流形态可能是折中:以数据驱动的方式去实现流程和代码的自适应和自演化,但在某一时刻这个流程和代码还是在那里有据可查的,这也给了人类去精确干预的途径(直接看懂代码并修改)。

@肖然:这个观点挺好,可以作为传统流程驱动的一个补充

茹炳晟:

过去二十年中国软件最擅长的是把欧美的成熟模式拿过来,做本地化、做实施、做低价替代,本质上是个应用层组装厂。现在欧美也在摸索,谁都没标准答案,这意味着没现成图纸可抄了。对于软件工程师真正的机会反而不是去追大模型(追不起,也不该追),而是“蹲下来”,把中国那些全球独一份的复杂场景翻译成AI能消化的数据。义乌小商品城的跨境报关、中国制造工厂的多品种小批量排产、基层政务里那些“原则上不允许但又经常特批”的模糊流程,这些东西国外没有,GPT也没见过。谁能把这些藏在老业务员脑子里、压在纸质审批单底下的“隐性知识”挖出来,结构化、对齐、喂给模型,谁就在定义下一代企业软件的门槛。

观点讨论

@王昊奋:说得好,不用所有人都去干基模的事情,有太多事情值得做,所以定位好新时代的工程师,站在AI这个巨人肩膀上,结果导向,业务优先,利用架构思维大有可为

沈欣:

落地第一,好的工程架构应该在AI只有80分的时候就能够产生生产力

目前不要重新发明轮子,先把低代码+AI迭代掉,就有能看得到的价值了.

解耦第二,不能绑死在某一个AI 上。

第三尽快构建人和AI的边界和协作体系:

1.用户/请求 → AI调度(你是谁,想干嘛,记住你)

2.AI调度 → 知识中台(这事有先例吗,该按什么流程做)

3.知识中台 → 数据中台(取原始数据印证) + 算法中台(调预测模型输出概率)

4.AI调度 → 业务中台(执行确定性计算) + 逻辑中台(执行硬编码决策)

5.AI调度 → 连接层(去逻辑中台把这件事办了)

6.所有环节日志 → 数据中台(反哺,用于优化算法和知识)

第四,要尽快构建企业级的数智库,30年前大部分企业没有数据库,现在几乎都有,这一块市场巨大。

最后,实时求是,与时俱进,要去拥抱变化。不要怕困难,我在2003、2004年研发低代码平台时,困难比现在大多了[呲牙]

朱征宇:

在未来的五到十年,不仅软件行业,各行各业都会因为智能化而进行深刻的变革。尤其是AI在工业场景的落地,将会带来生产力的爆发。相应的,人才的需求将从劳动密集型转向判断密集型。从而,大量基础岗位会被AI取代,而综合性人才特别稀缺,形成AI时代的“人才马太效应“。这样就会产生一个人才断层的危机。原先,通过线性积累实践经验、逐步成长为资深专家的职业阶梯会消失。这会引发教学模式的变革。

跨学科的场景案例的讨论比知识传授更重要。比如,讲操作系统时,讨论微内核/宏内核、软实时/硬实时的应用场景和设计理念;讲软件工程时,讨论系统论,控制论、信息论,以及软件工程背后的经济学规律和社会心理学规律。

对于学生和软件工程师:

1. 问题定义能力:随着知道的越多,未知也就越多,需要解决的问题也就越多,AI帮助我们减少重复劳动的同时,也在加速拓展新的问题域

2. 系统思考能力:手写的代码可能越来越少,但是系统思考只会越来越多。越是依赖 AI,越要具备“一眼看穿缺陷”的能力。

3. 架构设计能力:设计永远需要考虑好用性、可靠性、性能、质量、安全、合规、可观测性、可维护性等基本准则。根据场景选择合适的技术以及技术组合。

4. 跨领域的知识:目前懂工艺的不懂AI,懂AI的不懂工艺。

5. 人机协同能力:人在环中,一是定义规约和边界,一是随时监控和接管,承担兜底责任。

王楠:

-我也觉得现在很难预测未来五到十年的变化,因为发展的加速度太快。我去年12月在规划的时候,我有两个判断,其中一个预判是开源模型的工具使用能力会在2026年爆发,另一个是类似cc的应用会破圈,但是我没想到在2026的2月这些都实现了。但是我们可以预测方向。单agent扩展到agent群体协作,从顺序执行到并行执行,从简单任务到复杂任务,从人类编排到模型自主编排。从计算机的电子世界扩展到周边的原子世界。

– 关于中国软件,我认为中国有两个独特优势。第一,芯片自主化与AI并行推进,比如GLM-5完全用国产芯片完成推理。第二,部署规模优势:中国AI在将AI能力嵌入实际业务流程的速度和深度上都有优势。

– 对于工程师,我的建议只有两条:保持好奇和亲自上手。很多人问我LLM已经会写代码了,那程序员怎么办?但实际上,即使现在Opus 4.6这么强大,依然会需要人类,只是工程师角色正在从”Writer”转向”Reviewer”——不是写QuickSort,而是看着AI生成的QuickSort立刻发现不稳定pivot。而这些的洞见,其实如果你不上手去用AI工具是不可能了解的。AI的悖论是,它越强大,人类判断力越有价值。”动手”不只是学会用AI工具,更关键的是保持并提升判断AI输出好坏的专业能力。

王禹程:

未来 5-10 年,软件会从“卖功能/卖座位”走向“卖结果/卖行动能力”,核心竞争变成:谁能把数据、工具与治理做成可复用的 agent 组件。标准化也在加速:OpenAI、Anthropic、Block 在 Linux Foundation 下推动 AAIF,并把 MCP 等关键技术纳入开放治理,意味着互操作会更快成熟。 对中国软件:用行业数据治理与合规做护城河,围绕开放协议做连接器与可信插件生态,并探索 usage/outcome 定价。对工程师:从“写业务逻辑”升级为“定义意图、编排代理、做评测与安全治理”。

软件的“工具属性”正在坍塌,“伙伴属性”正在崛起。对于中国的软件从业者来说,最好的防御就是进攻——不要等到传统的 SaaS 围墙倒塌,而要主动拆掉围墙,构建一个能够自我进化、具备可编程灵魂的代理原生生态系统

谢吉宝:

5-10 年太长了,不好判断,我说一下 1-2 年我觉得就会发生的事:

● 未来会从“AI功能点缀”走向“AI成为默认交互层”,软件会变成:前台是Agent,后台是系统底座

● 竞争焦点会从“功能堆叠”转向:数据资产 + 工作流闭环 + 交付与运营能力

对中国软件产业的建议

● 做深行业Know-how:金融、制造、政务、医疗这类领域,谁把流程、合规、数据打通,谁就有护城河

● 把Agent当新平台做:工具生态、权限体系、日志审计、评测运营——这些是平台级能力

对软件工程师的建议

三个要补的能力:

○ 会用AI写代码(这几乎已经变成基础能力,有些公司入职已经直接考用 AI 完成功能)

○ 会把AI接进系统(工具调用、评测、监控、权限、安全)

○ 会做业务抽象与流程设计(AI再强也需要你定义边界和护栏)

我认为未来更值钱的工程师画像:“懂业务的系统工程师 + 懂AI的产品工程师”。

最后,还想说:AI会替你写很多代码,但不会替你为系统负责。真正的壁垒会回到:数据、流程、工程、合规和交付。

观点讨论

@王楠:机器比人可靠,只是人类没办法完全相信机器。类似无人驾驶,其实机器驾驶要比人类安全。

@彭鑫:自动驾驶里也存在AI的一个致命问题,那就是能力增长不连续:人类司机随着经验的积累一般会犯低级错误了,而AI一方面基本能力越来越强另一方面随时可能会犯低级错误

@彭鑫:而且人可以为自己负责,例如一个人追求谨慎那就可以控制好自己每次开车谨慎一点,而一个开车很猛的人可能也能接受他自己的风险比别人高的事实。但当我们把这个委托给AI之后,我们就失去了这部分的把握了。

观点讨论

@茹炳晟:我们现在安慰自己说“AI是工具,人才是创造者”,这话对了一半。以前我们是用手艺换价值——我会写你不会写,我值钱。以后AI会写了,我们的价值锚点必须从“产出能力”迁移到“风险承担意愿”。你敢不敢在模型输出的代码上签自己的名字?你敢不敢对业务方说“这个单子让Agent跑,出事了找我”?这不是技术问题,这是人性问题。能适应的人会成为新物种,可以暂且叫作“主理人”;适应不了的人会发现自己成了质检流水线上的熟练工,一遍遍修着模型生成的边界条件,像十年前的打字员。

@王楠:除了责任,另一个角度是利益。作为一个熟悉业务的高级员工,把业务逻辑都讲清楚,之后由agent去运行后,员工的是否还能从agent产出的结果中受益,或者说agent的收益应该有谁拿走。

@茹炳晟:好问题,一个过渡阶段的新命题是,如何挖掘“暗知识”,暗知识如何有效变现[坏笑]

@沈欣:变现是另一个故事,对企业来讲,要设立首席知识官角色才可能持续建设知识体系

@茹炳晟:是的,新的知识体系还好说,很多老系统的旧知识体系挖掘就像考古,还是有难度的,怎么激发人

@沈欣:这就涉及到生产关系的变革了

@茹炳晟:是的,更大的话题了

@茹炳晟:关于问题5,我再多说一个观点:要相信农村包围城市,哪些还没有被满足的,大厂看不上,小厂做不来的业务需求,会是我们软件智能化变革的发力点和切入口。FDE模式+业务风险可控是巨大的初期优势。

访谈结束

CodeWisdom

一个有知识的软工公众号

发现智能化编程之道

夜雨聆风

夜雨聆风