制作dify中的爬虫插件smart_web_crawler

“缘来则聚,缘去则散“

【说明】

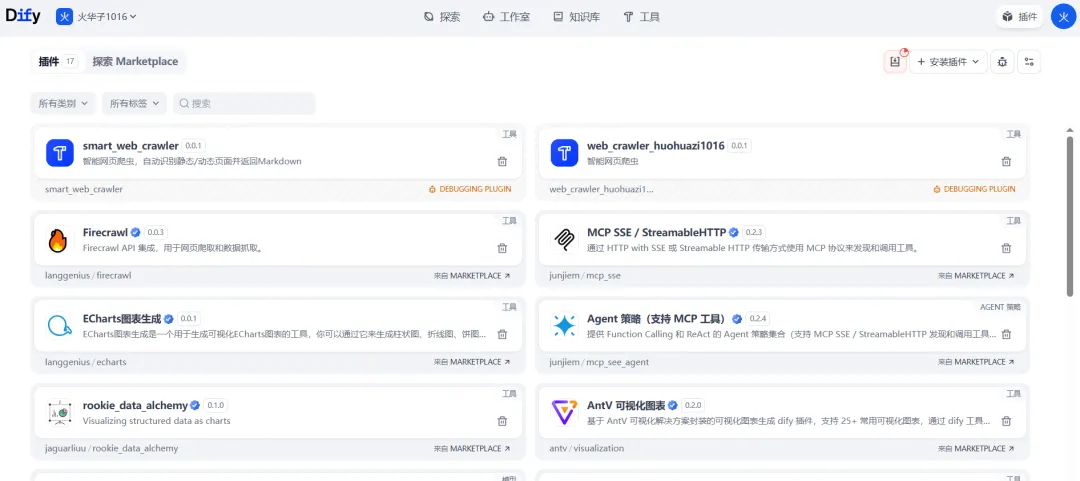

看了dify中的一些插件,例如Firecrawl,WaterCrawl,后边就会涉及到付费,自己就想着制作一个插件,顺便熟悉一下制作插件流程,本次用来测试,成功后会直接开源,大家用起来也方便,下边输出自己的具体步骤。

通过爬取网页内容,在通过LLM总结分析爬取到的内容,后边就可以做很多很多...

【前置条件】

1 准备一套好搭建的dify环境

2 准备一套搭建好的Visual Studio Code环境

3 安装python

4 Windows10系统

【具体步骤】

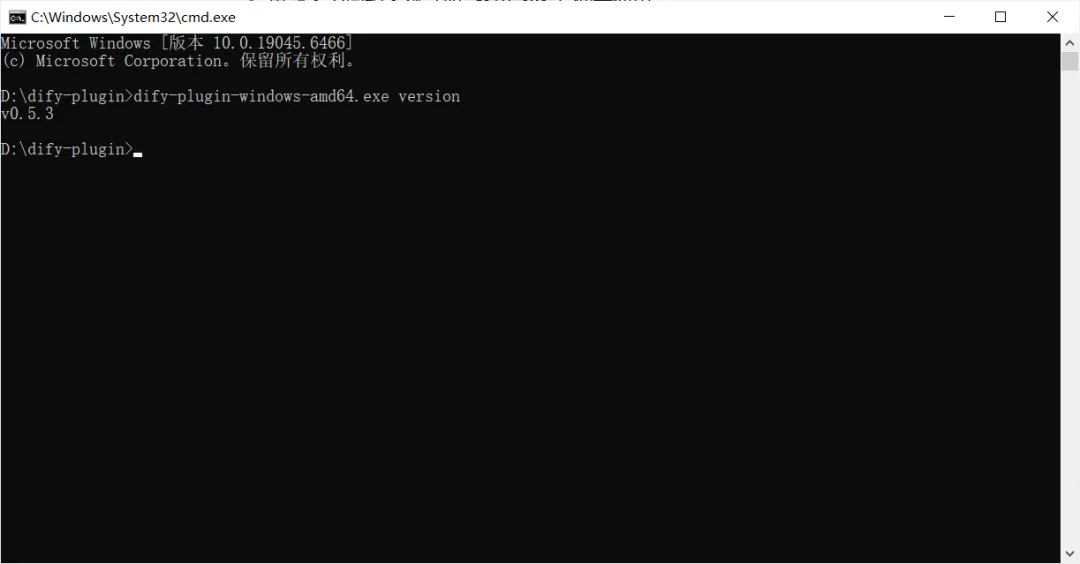

一 安装 Dify 插件开发脚手架

下载链接:https://github.com/langgenius/dify-plugin-daemon/releases

下载查看版本

二 创建插件项目并完成代码代码移植

1 配置python环境

# 创建虚拟环境(在项目根目录)python -m venv venv# 激活虚拟环境(Windows)venv\Scripts\activate

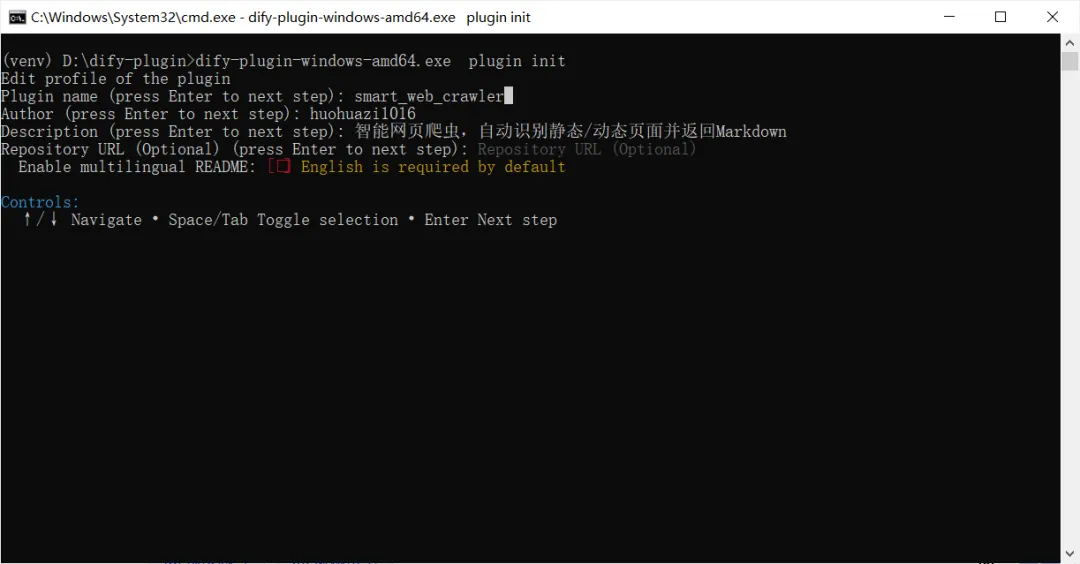

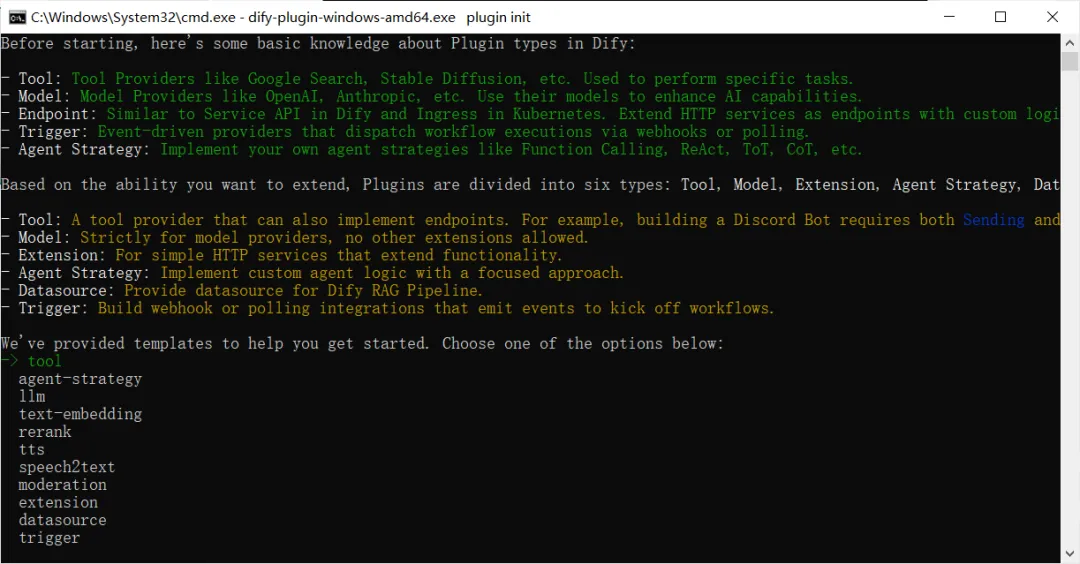

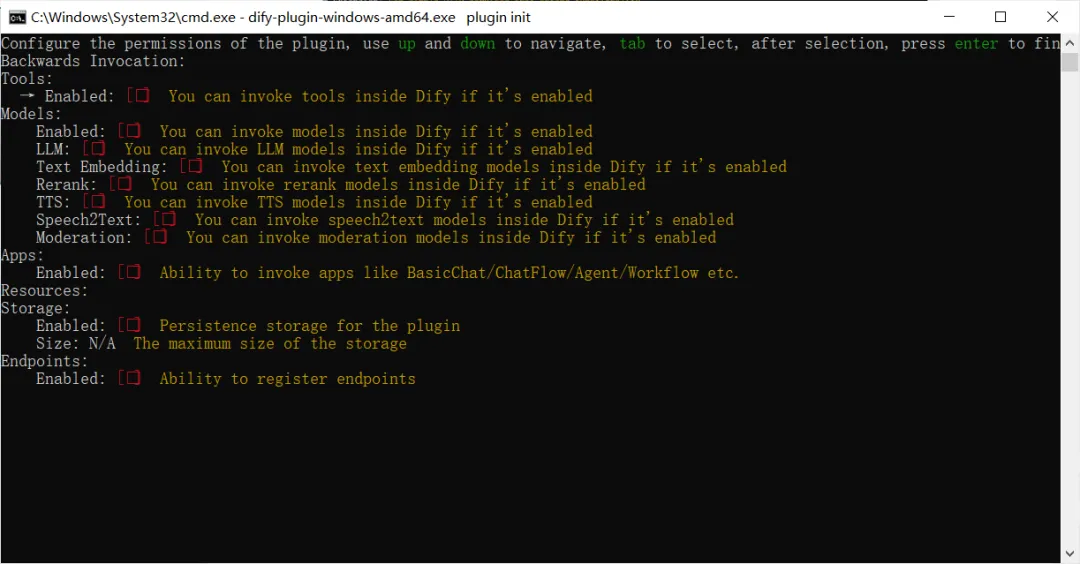

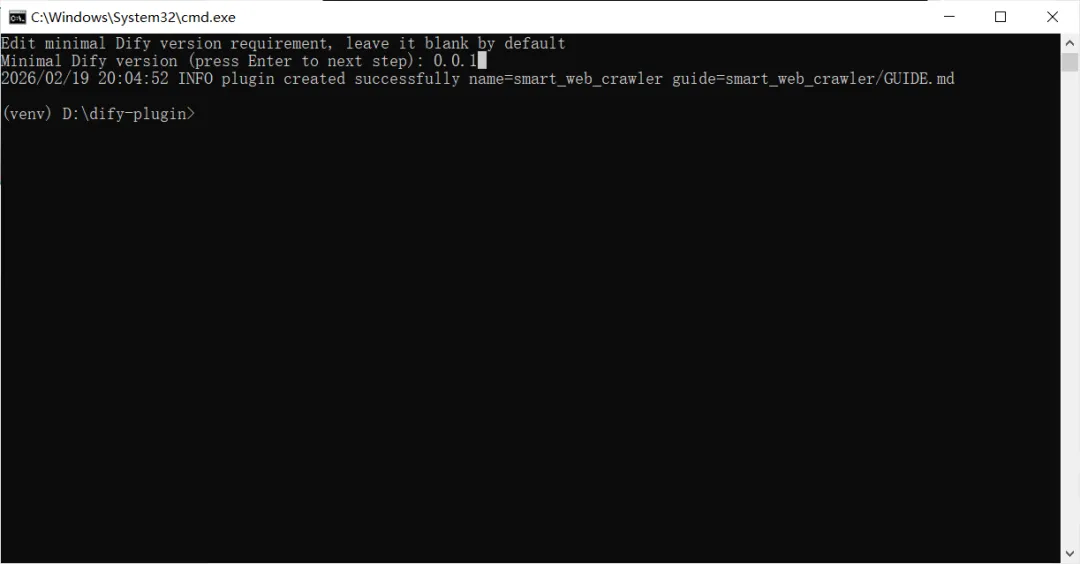

2 初始化插件项目

dify-plugin-windows-amd64.exe plugin init

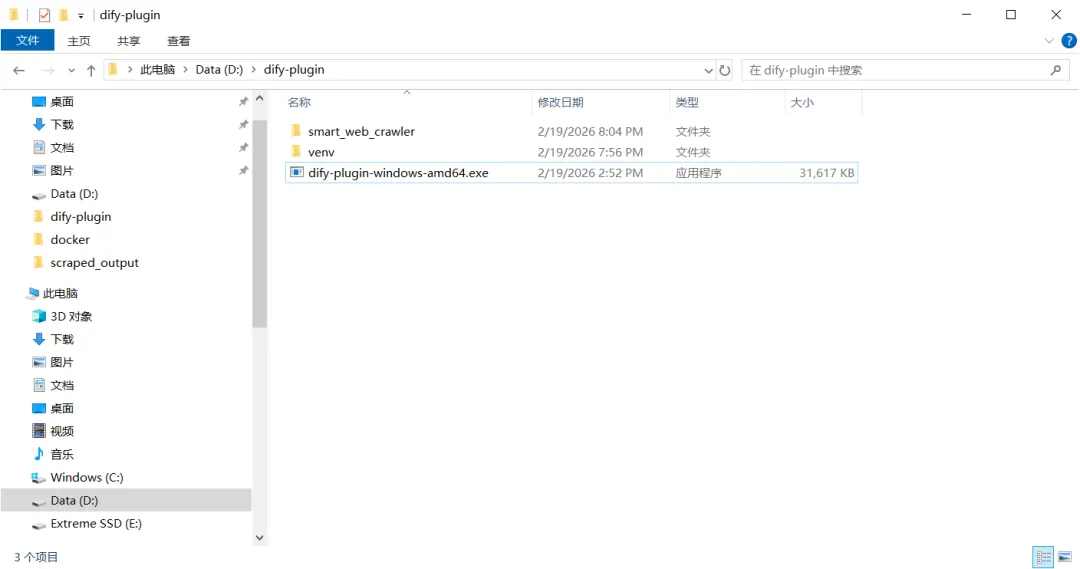

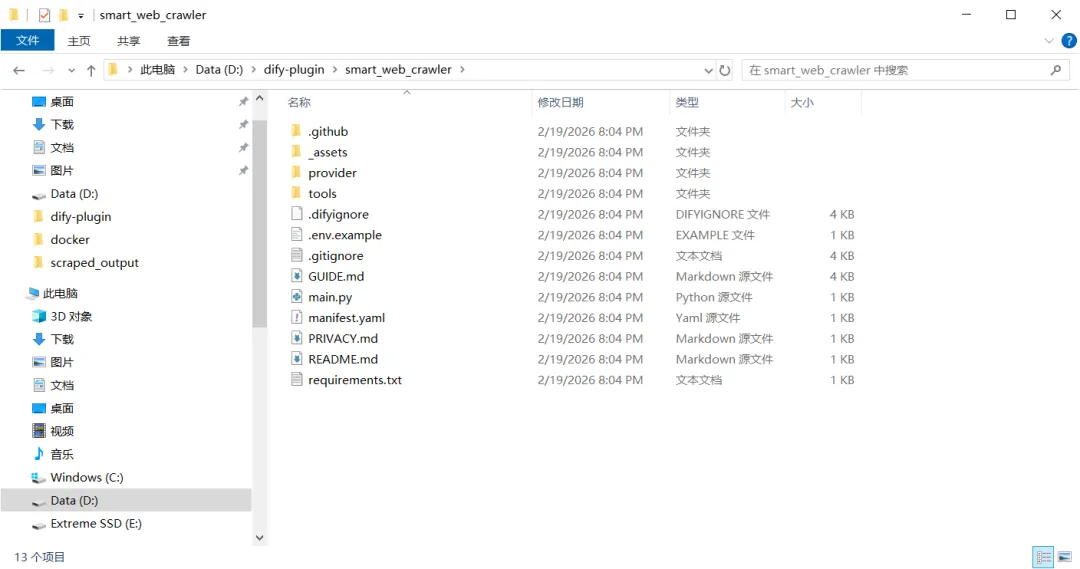

运行结束后新增内容

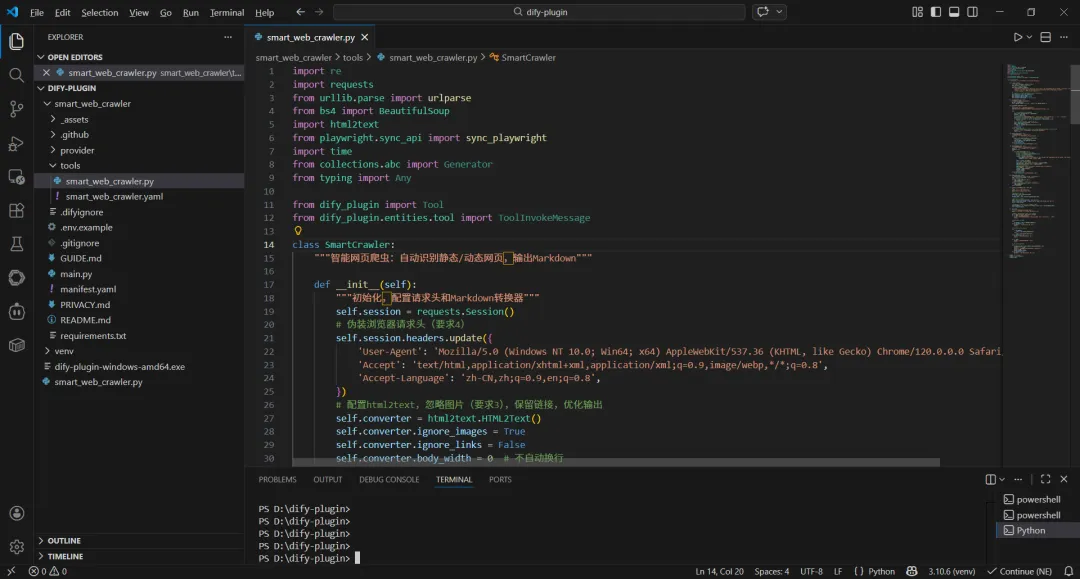

3 插入爬虫代码

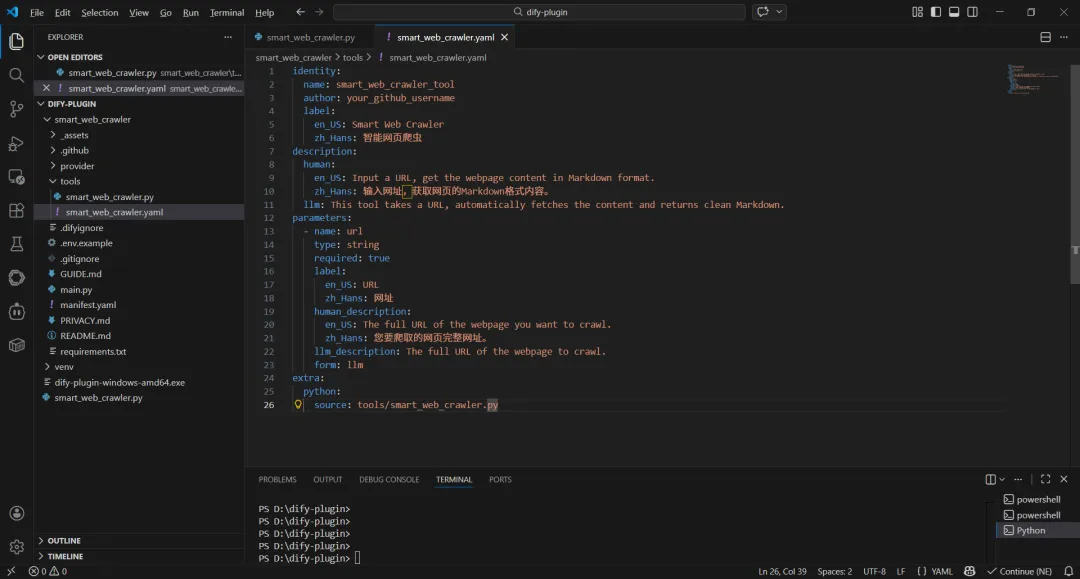

4 编辑 tools/smart_web_crawler.yaml

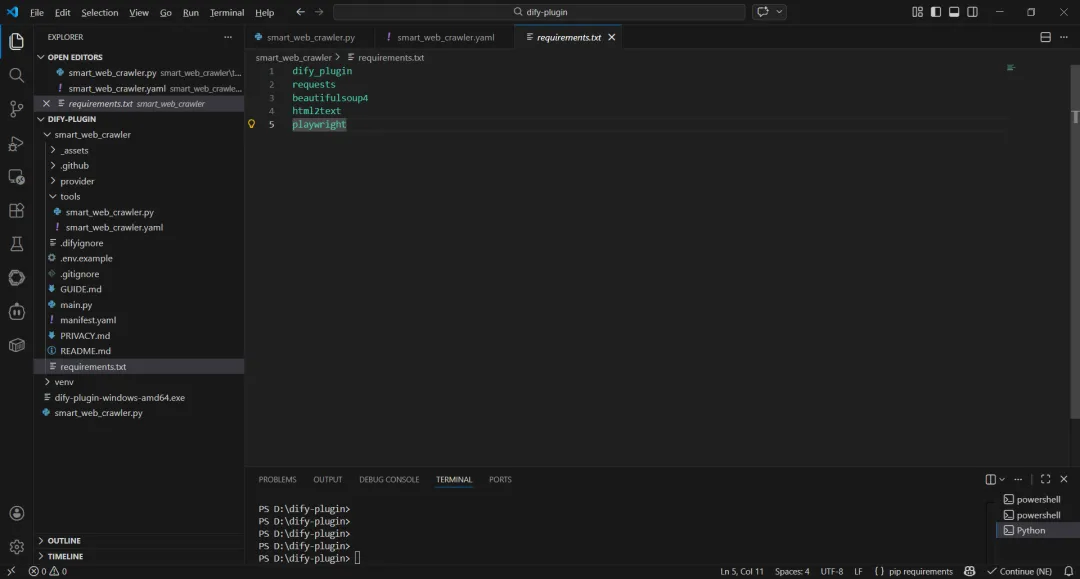

5 配置依赖文件requirements.txt

这里就是执行python代码需要安装的依赖库

三 本地调试

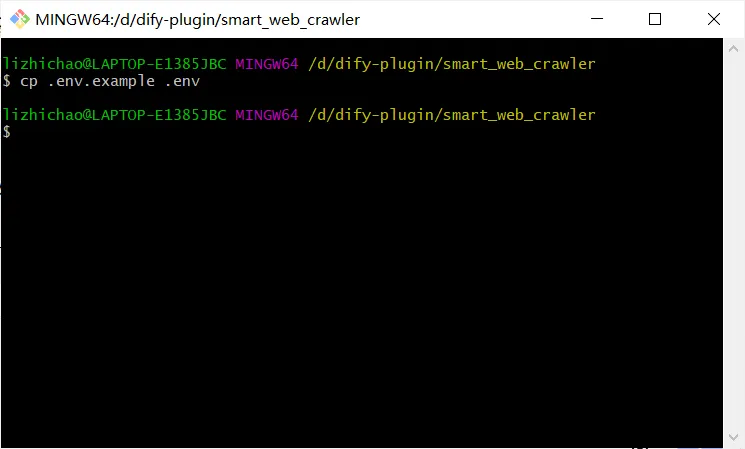

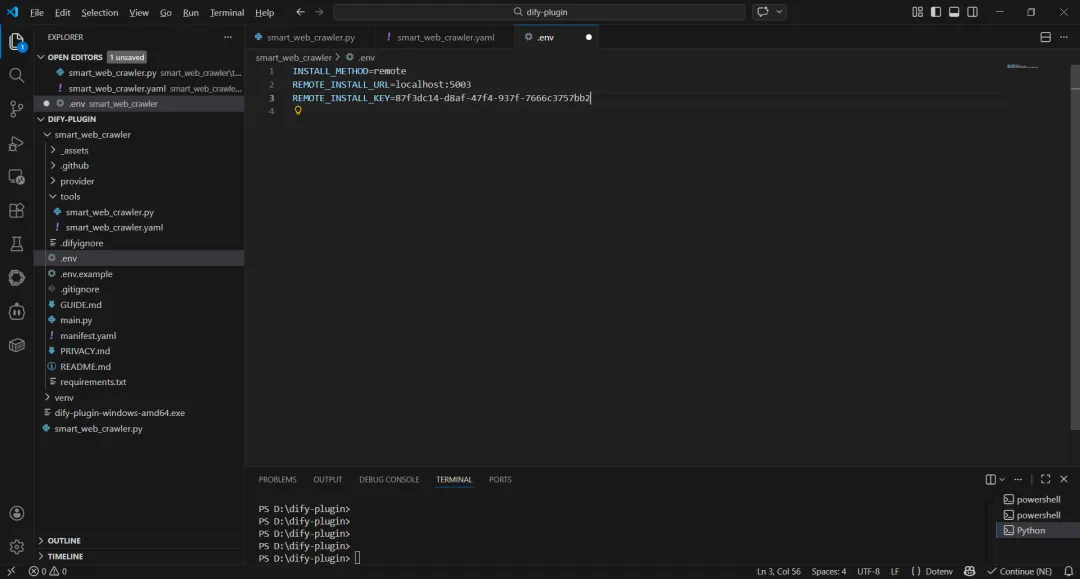

复制环境变量

获取远程服务地址和调试密钥

环境变量修改如下

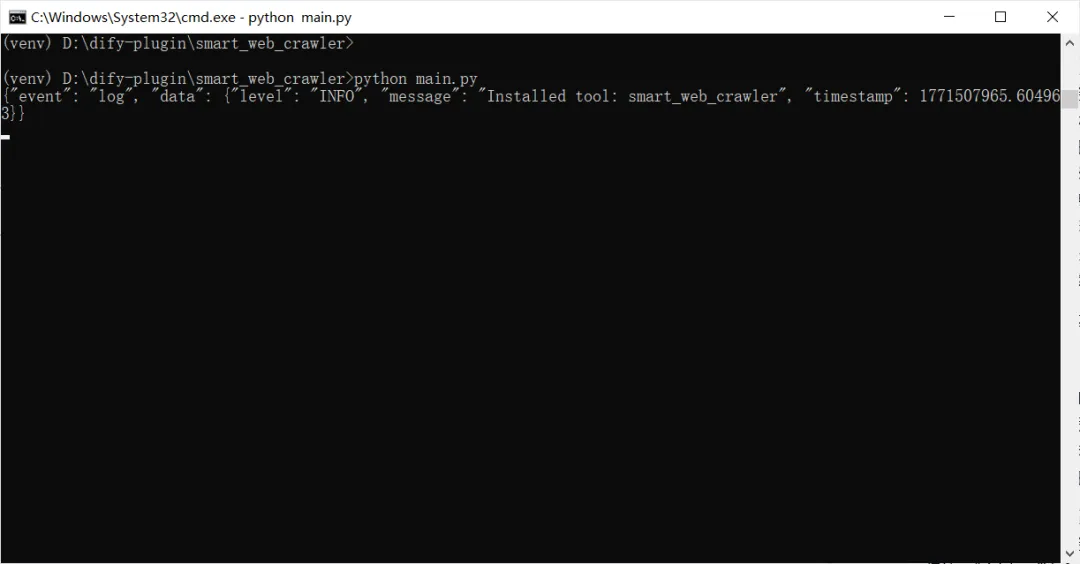

启动插件

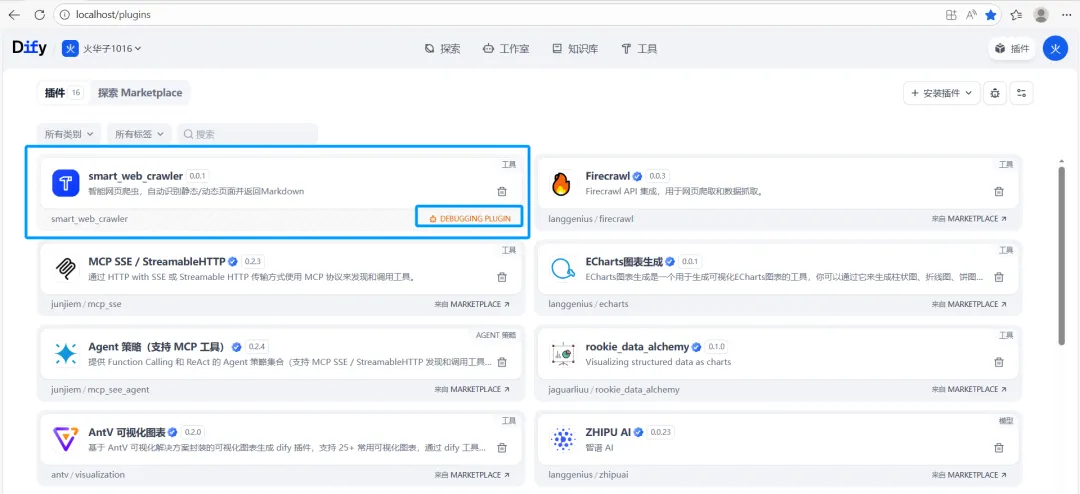

dify插件界面会出现下图,也就是可供调试用的插件

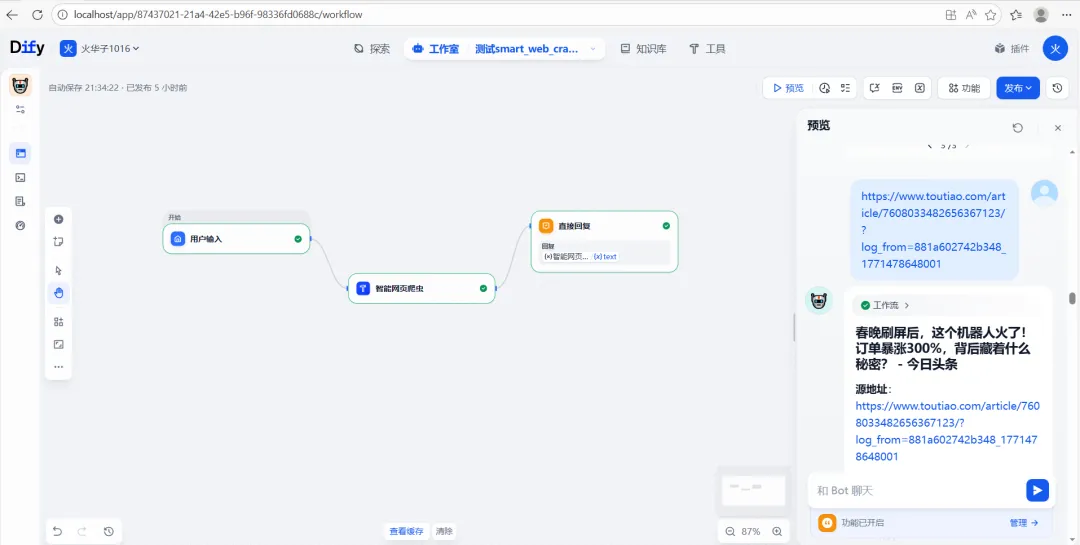

本地搭建工作流进行测试

测试成功

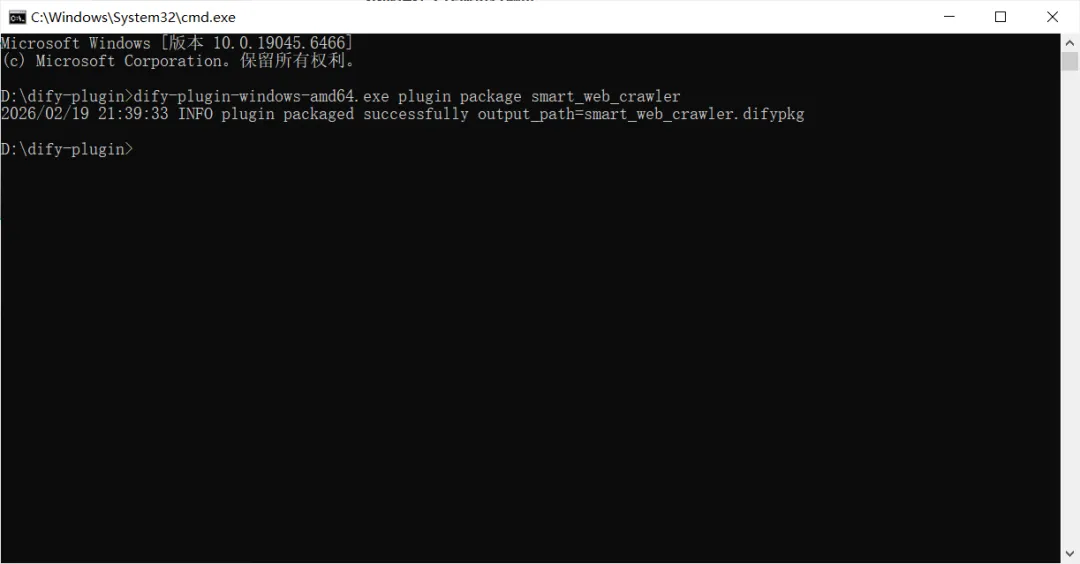

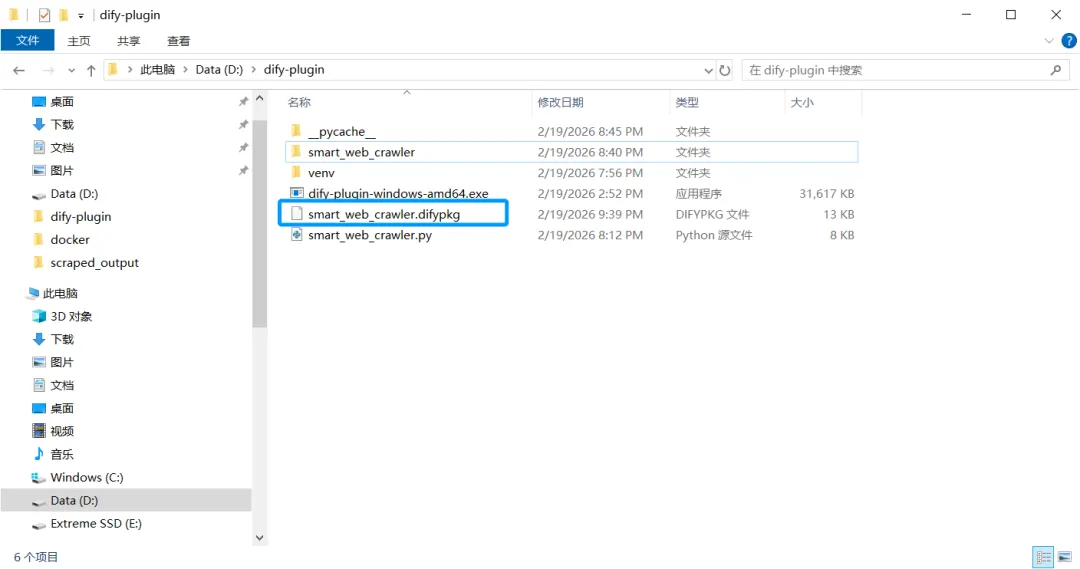

四 打包插件

dify-plugin-windows-amd64.exe plugin package smart_web_crawler

五 上传dify平台

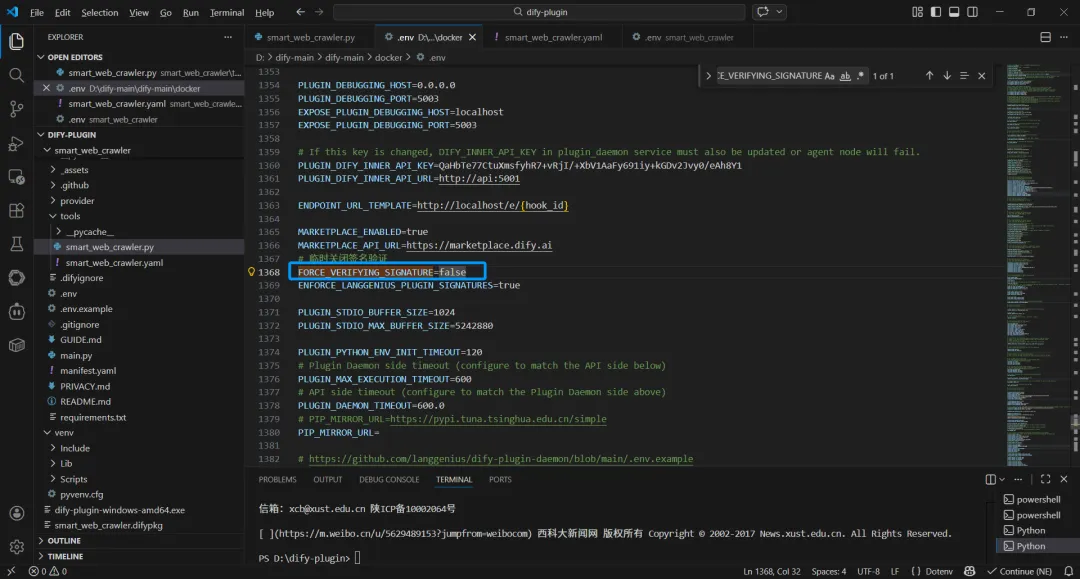

关闭临时签名认证

这里用来测试,正式发布强烈建议还是需要生成公钥和私钥认证的方式

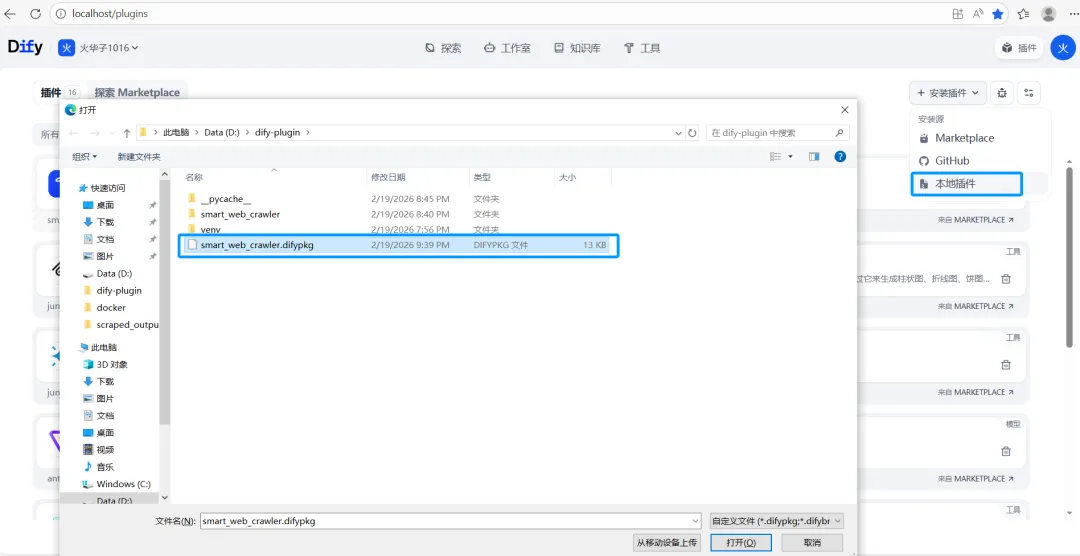

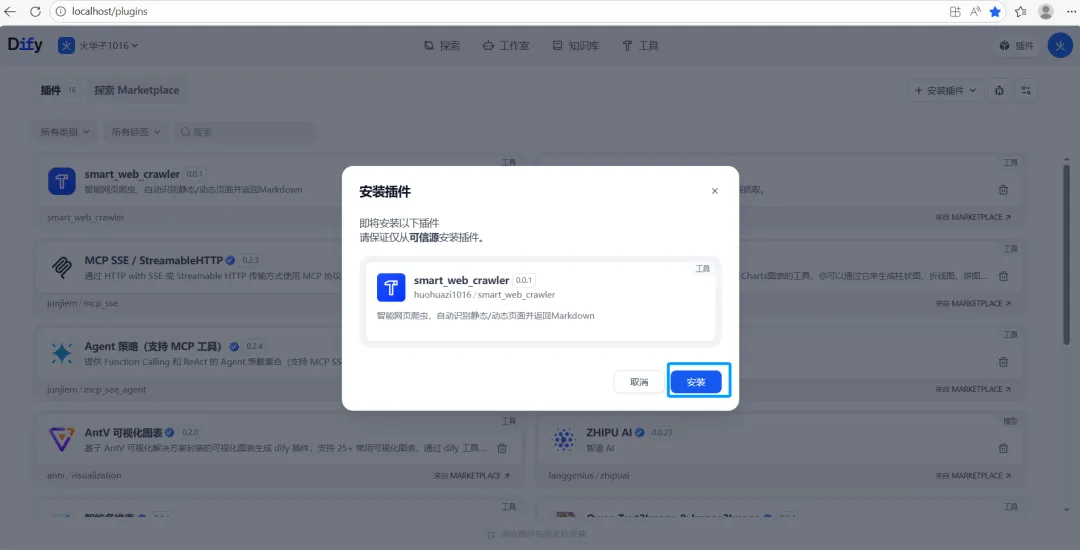

向dify中上传本地插件

点击安装

安装中

––结束

点赞 关注

关注

宝子们如果觉得还OK,可以动动可爱的小手分享给身边的好朋友!我们一起进步,每一个点赞关注分享都是小编前进的动力!

宝子们如果觉得还OK,可以动动可爱的小手分享给身边的好朋友!我们一起进步,每一个点赞关注分享都是小编前进的动力!

【往期回顾】

夜雨聆风

夜雨聆风