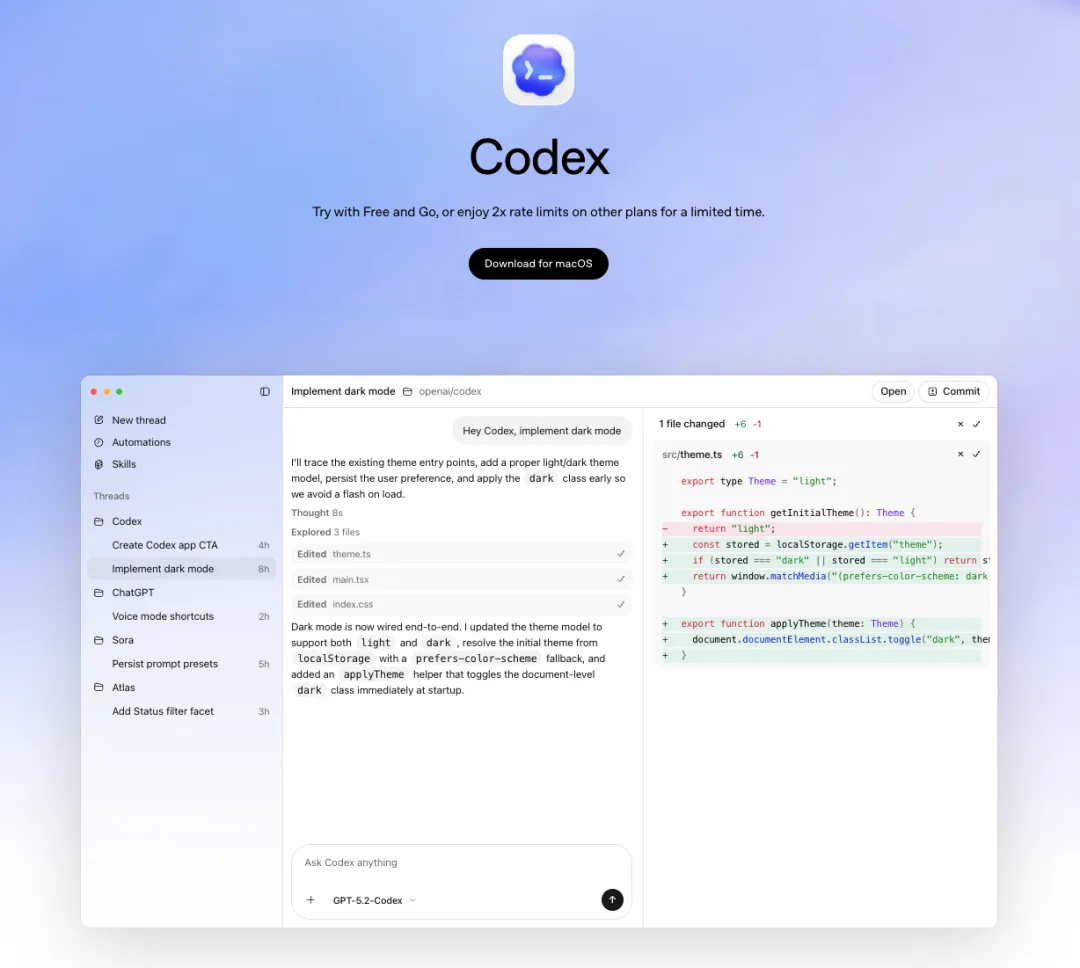

OpenAI发布Codex App,奥特曼下血本!限时「免费用+2倍速率」

我们都经历过这种时刻:让AI重构一个模块,结果它直接搞乱了本地环境,或者我们不得不傻坐在屏幕前看着代码逐行蹦出。2026年2月3号发布的OpenAI Codex App,似乎终于找到了解药。

这款针对macOS的桌面端应用,并非只是给ChatGPT套了一个Electron的壳。它最令人兴奋的工程创新在于后端对Git Worktrees的隐式集成。这意味着以后你可以同时开启三个并行的Agent线程,一个在后台重构数据库Schema,一个在更新前端组件,还有一个在跑测试,它们各自运行在独立的文件系统沙盒中,互不干扰,且主分支毫发无损。

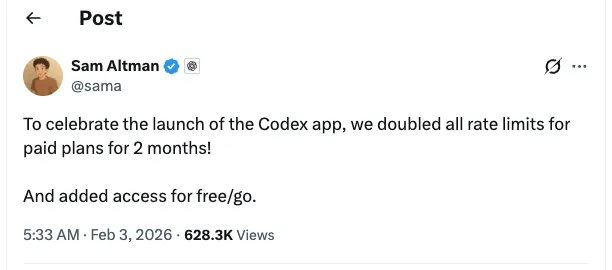

结合GPT-5.2-Codex的长上下文能力,OpenAI实际上交付了一个异步的、非阻塞的开发环境。对于习惯了CLI和即时反馈的专业开发者来说,这可能是第一款真正值得常驻Dock栏的AI原生IDE指挥中心。并且奥特曼推出了为期两月的限时活动,免费用户现在可以直接用,但有速率限制。如果你是OpenAI的付费用户,当前时间节点使用Codex App将比以前多一倍的用量。

核心设计:为“Vibe Coding”而生

界面交互范式的重构

OpenAI Codex App的设计哲学核心在于“管理”而非单纯的“生成”。在传统的IDE插件或终端CLI工具中,AI通常以单线程、同步阻塞的方式运行,即用户输入指令,等待生成,然后审查。这种模式在处理单一函数或脚本时效率尚可,但面对跨文件重构、端到端功能开发或系统级调试时,其上下文切换成本极高。

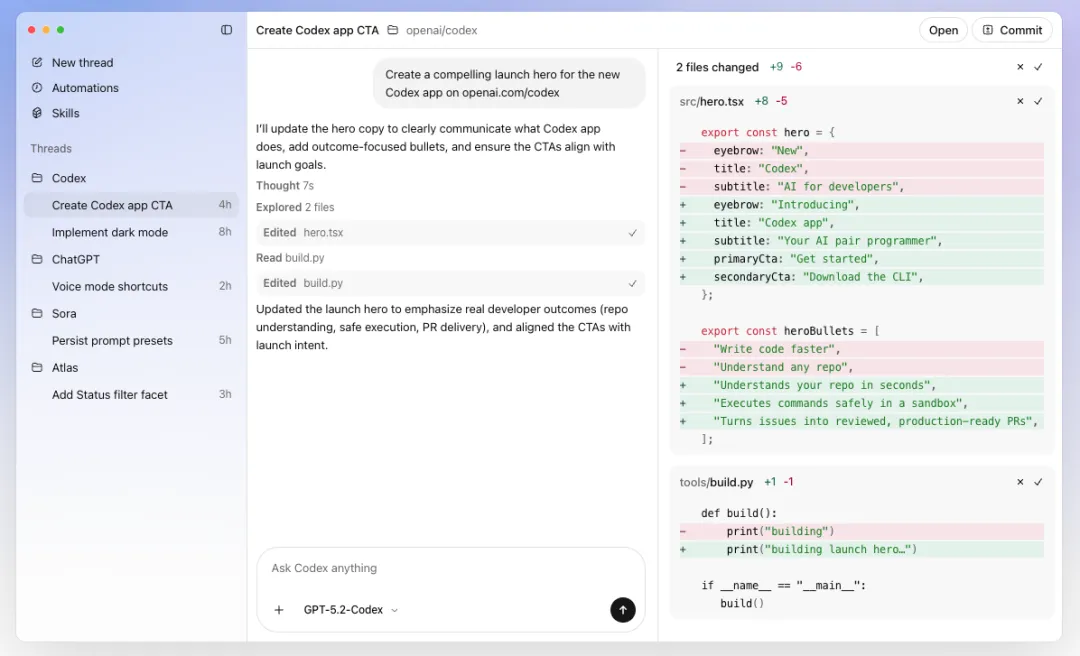

Codex App引入了项目侧边栏(Project Sidebar)和多线程视图,允许开发者在同一界面内同时指挥多个Agent。

模型基座:GPT-5.2-Codex的技术规格

支撑Codex App的核心是大模型GPT-5.2和GPT-5.2-Codex。

-

超长上下文窗口:GPT-5.2-Codex支持高达400,000 token的上下文窗口,约合100,000行代码。这一规格使其能够一次性加载中大型项目的完整代码库、依赖文档及历史Git记录,从而在进行全局重构时具备“上帝视角”。

-

多模态输入:模型不仅能处理文本和代码,还能直接理解界面草图(Interface Sketches)和多媒体输入。这意味着前端开发者可以直接上传Figma截图或手绘白板图,要求Agent生成像素级还原的UI代码。

-

推理与思考时间:GPT-5.2-Codex被设计为在输出前进行更深度的“思考”。用户反馈显示,虽然其生成前的延迟较长,但生成的代码逻辑更严密,减少了包含“AI垃圾代码”(AI Slop)或无效占位符的情况。与Claude系列模型的对比,感兴趣您可以看下前几天的这篇文章:

功能深度解析:多智能体协作引擎

Codex App的核心竞争力在于其能够让单一开发者模拟一整个软件开发团队的运作模式。通过以下四大支柱功能,它实现了从“单体”到“集群”的跃迁。

并行线程与任务分发 (Parallel Threads)

在Codex App中,每一个“线程”(Thread)不仅仅是一次对话记录,而是一个独立的执行环境。开发者可以创建多个线程,分别对应不同的开发任务。例如:

-

线程A:负责重构后端的数据库Schema。

-

线程B:负责根据新的Schema更新前端React组件。

-

线程C:负责编写集成测试用例。

这三个线程可以并行运行,互不干扰。开发者可以在侧边栏快速切换,查看Agent A的进度,回复Agent B的询问,审查Agent C的代码变更。这种并行性打破了以往“写代码-等AI-改代码”的串行瓶颈,极大地提升了开发者的效率。

Git Worktrees:技术实现的杀手锏

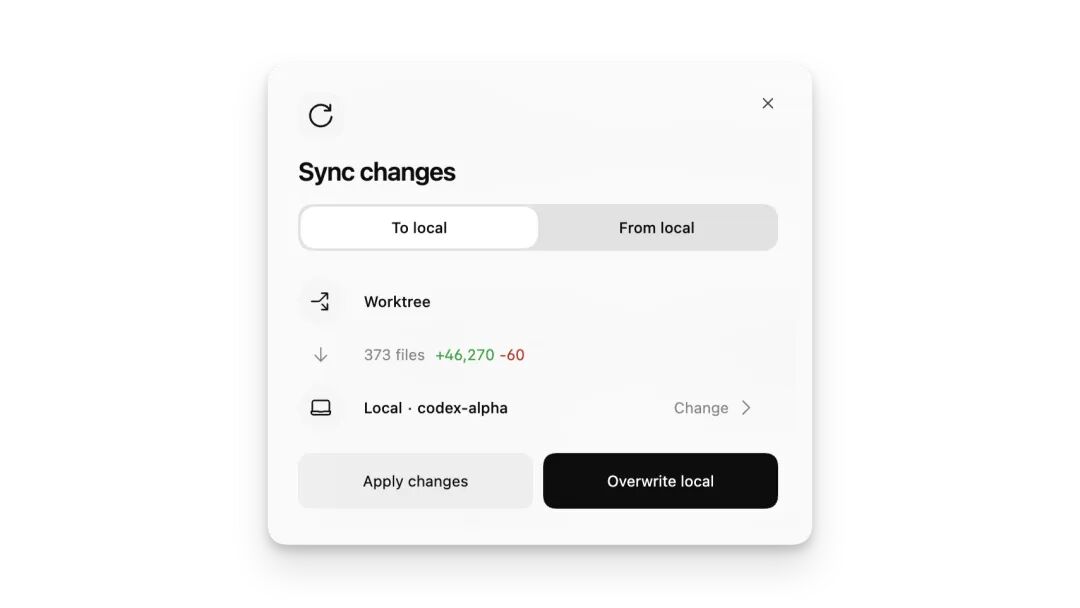

为了实现上述的并行协作且不造成文件系统的混乱,OpenAI创造性地在App后端集成了Git Worktrees技术。

技术原理

通常,Git仓库在同一时间只能检出一个分支(Branch)。如果多个Agent同时修改同一本地文件,必然会导致冲突或覆盖。Git Worktree允许在同一个仓库中同时检出多个分支到不同的文件夹路径。 Codex App利用这一特性,为每一个并行任务自动创建一个隐式的Worktree。

-

隔离性:每个Agent都在其独立的目录副本中工作,拥有独立的文件状态。Agent A的修改不会污染Agent B的工作区,也不会影响开发者主目录(Main Working Directory)的稳定性。

-

Detached HEAD:默认情况下,这些Agent运行在“分离头指针”(Detached HEAD)状态,这意味着它们在进行实验性修改时甚至不需要创建正式的分支,直到用户决定采纳其变更。

-

合并流:当Agent完成任务后,用户可以通过界面的一键操作,将Worktree中的变更合并回主分支,或者生成Pull Request。

场景应用

这一机制使得“破坏性实验”变得极其安全。开发者可以让Agent尝试升级一个核心依赖库,或者重写整个模块。如果Agent失败了,只需销毁该线程对应的Worktree,主项目毫发无损;如果成功了,则合并变更。这种“沙盒化”的开发体验是传统IDE插件无法提供的。

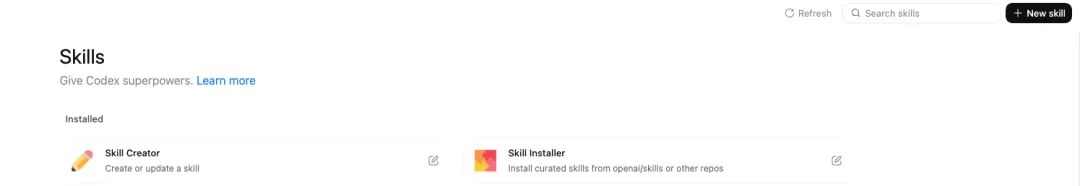

技能系统 (Skills):从指令到能力的封装

“Skills”是Codex App中预定义或自定义的可复用工作流。它超越了简单的Prompt工程,包含了指令(Instructions)、脚本(Scripts)和资源链接(Resources)。

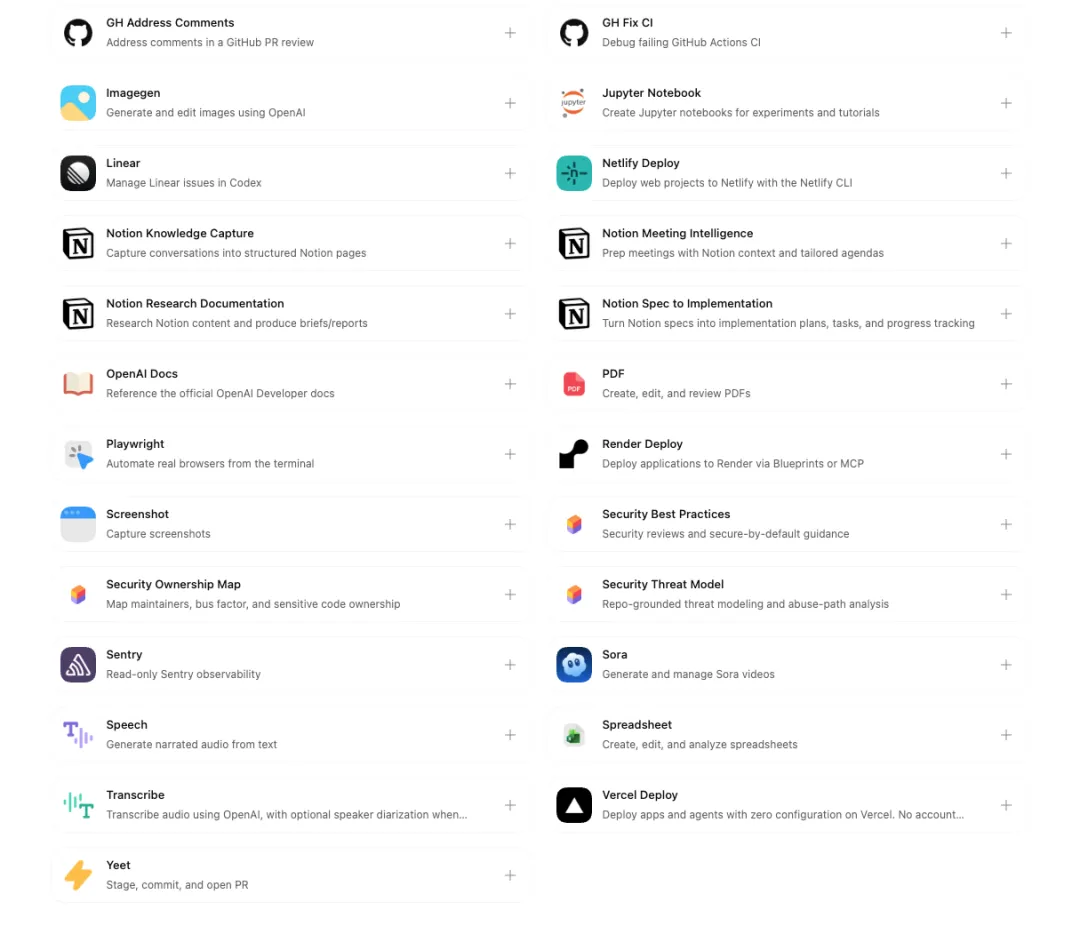

内置技能生态

OpenAI随App附带了一系列开箱即用的高频技能:

-

Implement Designs:连接Figma API,读取设计稿元数据,生成前端代码。

-

Manage Projects:集成Linear或Jira,允许Agent读取票据(Ticket)、更新状态、甚至根据Bug描述自动创建修复分支。

-

Cloud Deploy:对接Vercel、Netlify等云平台,自动处理部署流程。

-

Document Generation:自动生成PDF、Word文档或Excel报表,用于技术文档或数据分析交付。

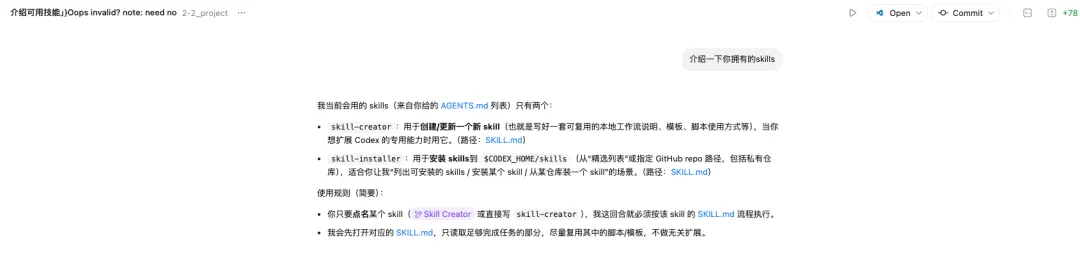

自定义技能与 skill-creator

为了适应特定需求,Codex App提供了强大的自定义能力。开发者可以使用内置的 skill-creator 工具,通过自然语言对话生成 SKILL.md 文件。

-

标准化:团队可以将代码规范(Linting rules)、提交信息格式(Commit conventions)封装成一个技能,强制所有Agent遵守。

-

共享机制:技能文件可以存储在项目仓库的

.codex/skills/目录下,随Git分发。这意味着任何拉取该仓库的团队成员,其Codex App都会自动加载这些项目专属技能,确保了团队协作的一致性。

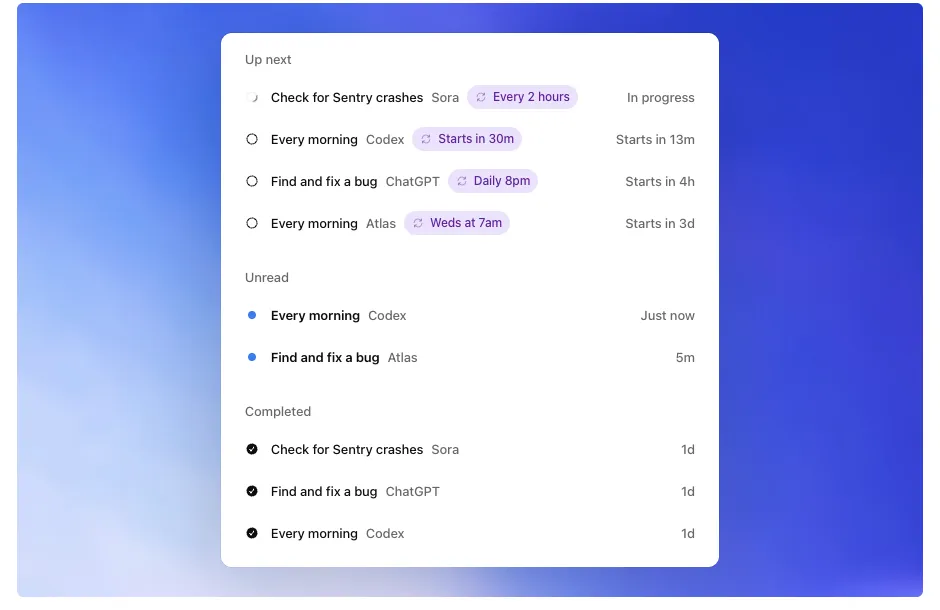

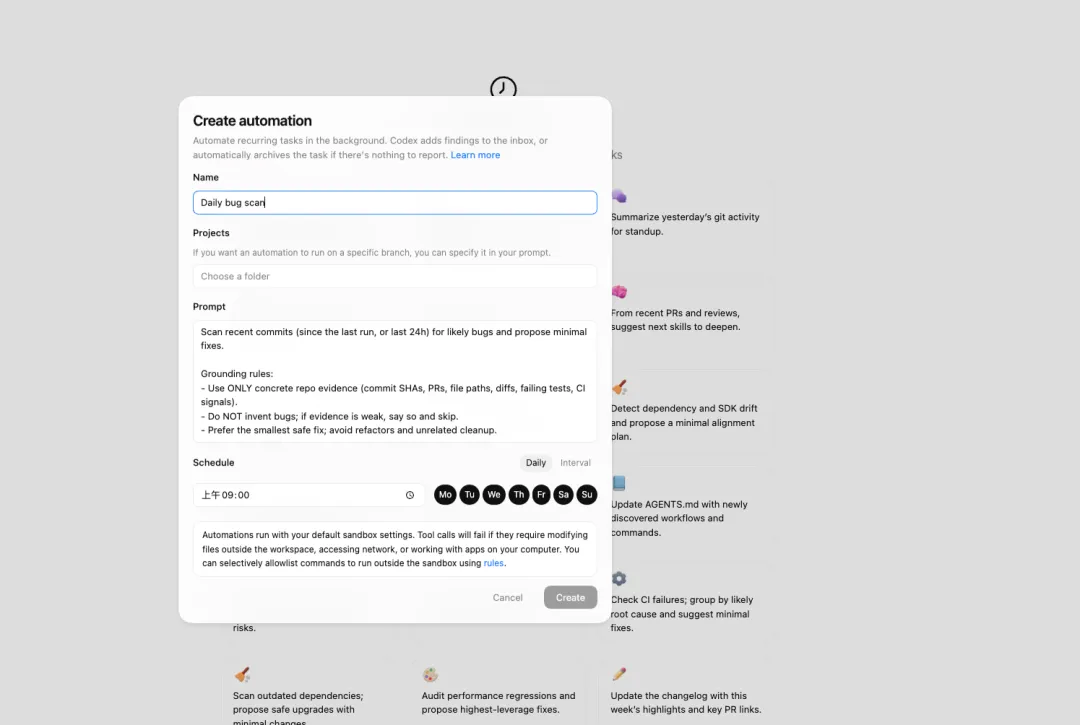

自动化 (Automations):后台常驻的虚拟员工

如果说并行线程解决了“即时”的多任务需求,那么“自动化”则解决了“周期性”的维护需求。

-

调度机制:开发者可以设置定时任务(如每天早上8点、每2小时、每周三),让Agent在后台自动唤醒执行特定工作。

-

应用场景:

-

每日分诊(Triage):扫描新提交的Issue,复现Bug,给出初步修复建议或标签分类。

-

CI/CD守护:每当CI构建失败时,自动分析错误日志,尝试修复并重新提交。

-

依赖更新:定期检查

package.json或requirements.txt,尝试升级依赖包并运行测试,生成更新报告。 -

审查队列 (Review Queue):后台Agent完成工作后,不会直接推送到主分支,而是将结果放入“审查队列”。开发者在空闲时可以像批阅邮件一样,快速浏览Agent的产出,决定是否合并。

这一功能实际上赋予了每个开发者一个全天候工作的“初级工程师团队”,极大地释放了人在琐碎维护工作上的精力。

平台支持与安全性

平台支持现状与局限

截至今天,也就是2026年2月3号,Codex App仅限于macOS平台。

-

硬件要求:必须运行在macOS 14 (Sonoma) 或更高版本,且仅支持Apple Silicon (M1/M2/M3/M4) 芯片。Intel Mac被明确排除在外。

-

Windows/Linux/移动端:Windows版本正在开发中,但由于Windows文件系统与沙盒机制的复杂性,发布时间未定。移动端(iOS/Android)目前没有官方独立App,用户只能通过移动浏览器访问Web界面,或使用第三方的“伴侣应用”来远程查看任务状态。

安全机制:沙盒与权限控制

将拥有文件读写和网络访问权限的AI引入本地开发环境,安全风险不言而喻。OpenAI为此构建了一套系统级的沙盒机制(System-level Sandboxing)。

-

文件系统限制:默认情况下,Agent只能读写当前项目目录及明确授权的Worktree目录,严禁访问系统敏感路径(如

/etc,~/.ssh等)。 -

网络权限分级:对于

npm install、curl或API调用等涉及网络的操作,App提供了四级权限控制: -

Untrusted(不可信):完全禁止网络访问。

-

On Request(询问):每次联网前弹窗请求用户批准(默认设置)。

-

On Failure(失败时):仅在常规操作失败时尝试联网查找方案。

-

Always(总是):对受信任的项目或操作完全放行。

-

企业级管控:企业版用户可以通过MDM(移动设备管理)策略统一配置这些权限,防止内部代码泄露或外部恶意脚本注入。

结论

从单线程的等待,到多线程的异步编排,Codex App确实击中了当前AI编程中最痛的那个点,上下文管理与环境隔离。不管你对“完全自动驾驶”的未来持何种态度,这款应用展现出的工程能力都值得你投入时间。

目前的发布窗口期是绝佳的入手时机。 OpenAI为了推广这款桌面端应用,不仅开放了免费(Free/Go)用户的访问权限,更对付费用户提供了2倍的速率限制(Rate Limits)。这意味着你可以毫无顾忌地开启多个并行线程,让Agent尝试那些以往因为担心Token消耗或上下文丢失而不敢做的“大规模重构”任务。

别等到Windows版发布或者速率限制收紧后再后悔。现在就去下载,建几个分支,看看当你有三个“硅基初级工程师”同时为你工作时,你的生产力极限究竟在哪里。

未来已来,有缘一起同行!

<本文完结>

-

转载请与本喵联系,私自抓取转载将被起诉

夜雨聆风

夜雨聆风