AI Agent热插拔架构:软件变成流体,从App到Agentic OS的进化之路

AI Agent 热插拔架构:重塑智能系统的”特修斯之船”

“真正的智能不仅在于思考,更在于如何在奔跑中重塑自我,且不曾停下脚步。”

2026:热插拔架构的元年

如果说2024年是AI模型的爆发期,那么2026年无疑是AI系统架构的重构期。随着企业级应用对稳定性、灵活性和成本控制要求的激增,传统的”单体巨型模型”(Monolithic Models)策略正迅速失效。取而代之的是一种全新的设计哲学——热插拔架构(Hot-Swappable Architecture)。

这一概念借鉴自服务器硬件领域的”热插拔”技术,即在不关闭系统电源的情况下更换组件。在AI语境下,它意味着企业可以在Agent运行过程中,动态地替换底层LLM(如从GPT-5切换到DeepSeek-V4)、更新Prompt策略、加载新的技能插件(Skills),甚至重组整个多智能体协作网络,而无需让业务停摆。

这种架构的出现,标志着AI Agent从”实验性玩具”正式进化为”企业级基础设施”。它不再是一个黑盒,而是一艘可以在航行中不断更换木板的”特修斯之船”,永远保持最新、最优的状态。

不仅仅是API切换:三层架构的进化

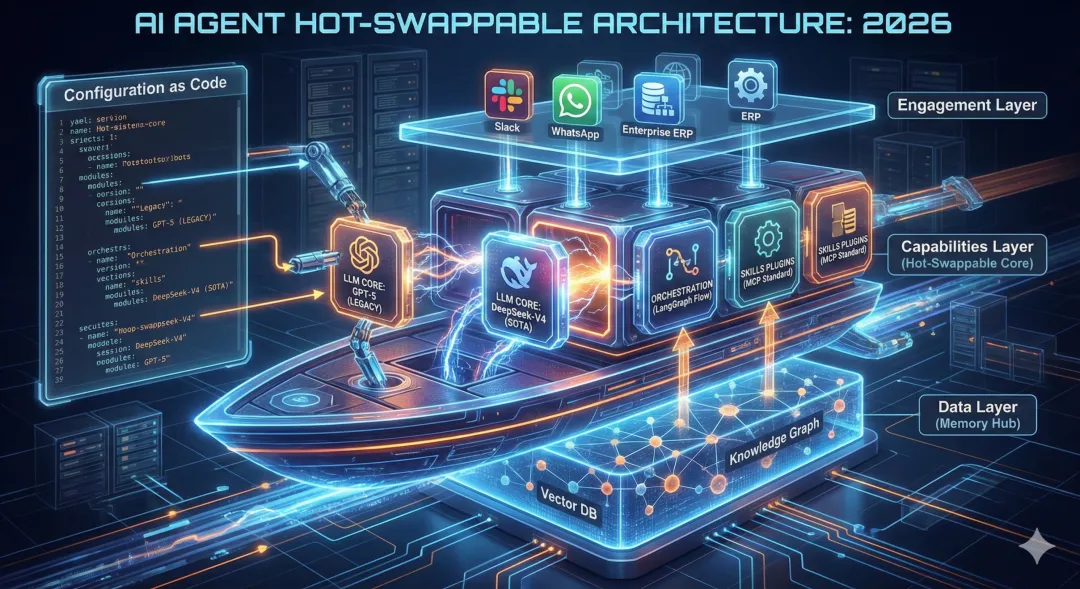

实现热插拔并非简单的API路由切换,而是涉及整个Agent系统架构的深度解耦。目前主流的架构已演进为清晰的三层结构:

- Engagement Layer (交互层)

:负责与用户的多模态交互。无论是WhatsApp、Slack还是企业内部ERP,这一层保持稳定,确保”换芯不换皮”。 - Capabilities Layer (能力层 – 热插拔核心)

:这是变化最剧烈的区域。它包含了核心推理引擎(LLM)、编排逻辑(Orchestration)和工具集(Tools)。通过标准化协议(如MCP, Model Context Protocol),这一层实现了”即插即用”。想要添加一个”高级数据分析”能力?只需上传一个标准化的Skill包,配置中心即可实时下发,Agent立刻获得新技能。 - Data Layer (数据层)

:系统的记忆中枢。为了支持热插拔,Agent的记忆(Memory)不再存储在模型内部,而是外挂在向量数据库或知识图谱中。这意味着即使你把”大脑”(LLM)换了,Agent依然记得你是谁,之前的对话也能无缝衔接。

这种架构最直接的红利是“反厂商锁定”(Anti-Vendor Lock-in)。企业不再受制于单一模型供应商,可以根据任务难度动态路由:简单问答交给低成本的小模型,复杂推理交给昂贵的SOTA模型,实现成本与效果的最优平衡。

Configuration as Code:驯服不确定性

如何在保持灵活性的同时,不让AI系统变成一团乱麻?2026年的企业级最佳实践指向了一个核心原则:Configuration as Code (配置即代码)。

在成熟的Agent平台中,Agent的行为逻辑、使用的Prompt模板、挂载的技能列表、甚至调用的模型参数,全部被抽离为配置文件(YAML/JSON)。

- 动态配置中心

:通过统一下发配置,瞬间改变全网百万个Agent的行为模式。 - 版本控制与回滚

:新上线的”销售话术Agent”转化率暴跌?一键回滚到V1.2版本,秒级恢复业务。 - 灰度发布

:只让1%的用户体验接入了最新Qwen-Max模型的客服Agent,验证效果后再全量推开。

这种工程化手段,将AI的不确定性关进了DevOps的笼子里,让企业敢于在生产环境中大胆使用Agent技术。

从App到Agentic OS

热插拔架构的终局是什么?它预示着我们正在迈向Agentic Operating System (智能体操作系统)。

未来的每一个应用,本质上都是一组Agent的集合。操作系统不再管理进程和线程,而是管理Agent的生存周期、资源分配(Token预算)和能力装载。当Agent需要画图时,OS动态挂载绘图模块;当需要编程时,OS瞬间注入代码解释器。

在这个新世界里,软件不再是静态的代码死物,而是一种流动的、可生长的、即时响应需求的智能流体。热插拔架构,正是构建这个流体世界的物理法则。

夜雨聆风

夜雨聆风