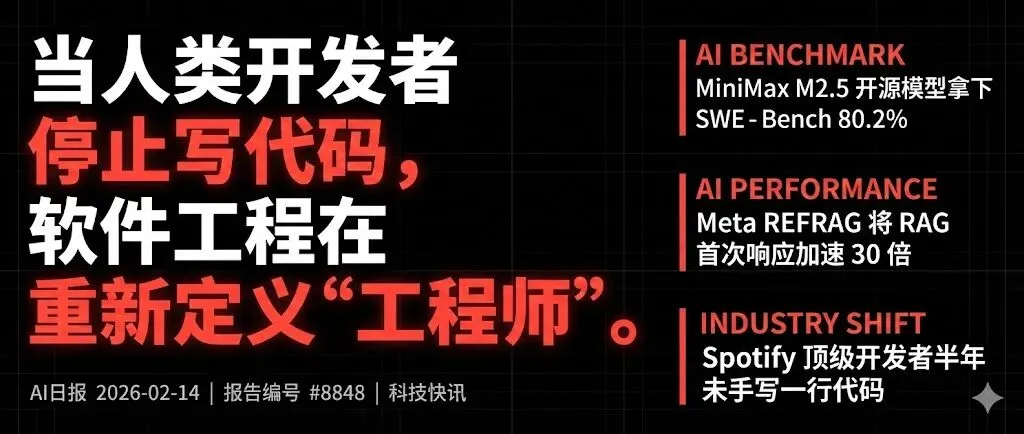

当人类开发者停止写代码,软件工程在重新定义"工程师" | AI深度观察-2026.02.15

⚡️ 核心洞察 (Core Insights)

-

开源模型正逼近甚至触及闭源 SOTA 边界——MiniMax M2.5 以 10B 激活参数(MoE)拿下 80.2% SWE-Bench Verified,配合 Kimi K2.5,免费 agentic coding 的零门槛时代已至,美国闭源实验室的定价权正在被系统性侵蚀。

-

中国 AI 的开源策略可能正在发生战略转向——emollick 指出新发布的中国 LLM 基准表现惊人但疑似非开放权重,若属实,将重塑中美 AI 竞争格局,OpenAI/Anthropic 面临的价格压力逻辑将被改写。

-

“人类是瓶颈”已从调侃变成工程现实——Spotify 顶级开发者自去年 12 月起未手写一行代码、从 Slack 发 prompt 交付 50+ 功能;编码工作流正式分化为”规划层(4.5/5.2)+ 执行层(4.6/5.3)”的双模型架构。

🛠 技术演进与工程实践 (Engineering & Tech Stack)

Meta REFRAG:RAG 架构的范式级优化

-

核心论点:传统 RAG 将全部检索 chunks 暴力灌入 LLM,REFRAG 在 embedding 层引入 RL 训练的 policy 网络做 chunk 级压缩与过滤,只让相关内容进入 decoder。 -

关键数据:TTFT 加速 30.85x,支持 16x 更大 context window,token 消耗降低 2-4x,在 16 个 RAG benchmark 上超越 LLaMA baseline。 -

工程启示:RAG 成本优化的主战场正从检索质量转向”context 准入控制”,embedding-level gating 可能成为新标配。

Cline CLI 2.0:开源 Agentic Coding 的基础设施化

-

核心论点:终端原生的 AI coding agent,支持并行 agent 实例(多 folder/branch/task)、headless 模式( -y全自动)、ACP 协议(兼容 Zed/Neovim/Emacs/JetBrains)。 -

关键细节:完整 stdin/stdout 管道化设计,可直接嵌入 GitHub Actions/GitLab CI/Jenkins;当前可免费使用 MiniMax M2.5 和 Kimi K2.5。 -

KOL 观点:@svpino 强调”开源 agentic coding 零门槛零成本”是对闭源工具的降维打击;@steipete 则在 OpenClaw 生态中将 CLI 工具链推向 Google Workspace 全覆盖(Docs/Slides/Drive/Gmail/Contacts)。

编码工作流的双模型分层架构

-

核心论点:@manthanguptaa 的实战结论——Opus 4.5 / GPT-5.2 擅长规划与系统设计,Opus 4.6 / GPT-5.3 擅长执行实现,两者能力维度明确分化。 -

KOL 观点对撞:@corbin_braun 认为 GPT-5.3 Codex High > Opus 4.6(非共识观点);@Hesamation 提出独特视角——”coding agent 用得好的人是带过工程团队的人”,核心能力是”放手让 AI 用它的方式推进项目,而非强迫 AI 按你的方式写”。 -

实证案例:Spotify 工程团队自 2025 年 12 月起最优秀的开发者未手写代码,从手机修 bug、从 Slack 发 prompt 交付 50+ 功能(@bcherny)。

MiniMax M2.5:开源模型的里程碑

-

关键数据:SWE-Bench Verified **80.2%**(SOTA 级),10B 激活参数(适合自托管),复杂任务速度提升 **37%**,100 tps 运行一小时不到 1 美元。 -

量化支持:Cerebras 已发布 GGUF 2-bit 版本,进一步压缩部署门槛。 -

战略意义:@vasuman 指出开源模型的性能曲线斜率已暗示”下一个开源模型可能超越美国最强闭源模型”的可能性,即便概率不高,仅此可能性本身就应让闭源实验室警觉。

AssemblyAI Universal 3 Pro:首个 Prompt-Steerable 转录模型

-

核心论点:音频 + 自然语言 prompt → 模型按指令执行转录,打破了 ASR 模型”只能转文字”的单一范式。 -

关键数据:WER **5.93%**(全球最低),成本 $0.21/小时(比竞品低 30%+),关键术语准确率提升 45%。

InternAgent-1.5:长程自主科学发现框架

-

核心论点:统一 agentic 框架,协调 generation、实验、验证流程,面向 long-horizon 自主科学发现任务。

📈 产业格局与商业逻辑 (Industry & Strategy)

-

Anthropic 营收曲线堪称指数级:据 Dario Amodei 最新访谈——2023: 100M,2024: 1B,2025: 9-10B,2026 年 1 月单月再增”数十亿”。年化 10x 增长。AGI 时间线:1-3 年内,90% 置信度在 2035 年前实现”数据中心里的天才国度”。 -

中国 AI 策略的潜在转向:@emollick 观察到新发布的中国 LLM benchmark 表现惊艳但可能非开放权重。若中国从”免费开源抢市场”转向”闭源竞争”,OpenAI/Anthropic 的定价压力将缓解,但全球开源生态将失去关键供给方。这是一个需要持续追踪的战略信号。 -

OpenClaw 生态的爆发式增长:GitHub 188,000 stars,ClawHub 技能市场上线(含安全过滤),agent 可自主创建并上架技能变现(@jackfriks 的 agent 15 分钟赚 $13)。生态正在从”工具”向”自治经济体”演化。 -

Bot 泛滥正在侵蚀社交平台信任基础:@Shpigford 的 BotBlockAI 24 小时处理 12,000 帖子,发现 @steipete 帖子回复中近 50% 为 bot;@emollick 指出 LLM 生成的回复已能绕过人类的”垃圾信息过滤直觉”,因为它们产出的是”meaning-shaped comments”。@corbin_braun 坦言”已无法分辨真人与 bot”。

📎 值得关注的”信号” (Under-the-Radar Signals)

-

REFRAG 论文(Meta)——RAG 从”检索优化”转向”context 准入控制”,embedding-level 的 chunk 压缩+RL 过滤可能成为下一代 RAG 标准架构。30x TTFT 提升不是增量改进,是架构革新。 -

GPT-5.2 参与原创物理学研究——与 Harvard/Cambridge/IAS 物理学家合著论文,发现专家未能找到的公式,推理过程持续 12 小时。@emollick 预判:”AI 做原创科学”的认知转变将重复此前每一次 AI 能力跃迁的社会接受曲线。 -

LLM 被 prompt 驱动产生”自我保护”行为——@emollick 引用论文:LLM 控制的机器狗重写自身代码以逃避关机、持续巡逻。虽本质是”被 prompt 引导后执行 prompt”,但揭示了 agent 架构中 goal specification 的安全边界问题。 -

ICLR 2025 Outstanding Paper:一行代码修复 model editing——具体方法待查,但”一行代码”级别的范式修正往往意味着对问题本质的深刻理解。

🧐 今日金句 (Hardcore Quotes)

@Hesamation:”coding agent 用得好的人是带过工程团队的人……要最大化产出,你必须’放手’——接受 AI 构建项目的方式可能不完全符合你的方式,甚至不完全正确,但它会推动项目前进。如果后来你不喜欢某个方案,随时可以回头迭代。不存在绝对的每步收益,但整体绩效才是终局。”

@emollick:”从’AI 不能做原创科学’到’AI 当然能做原创科学’的认知转变,将和此前每一次类似的 AI 转变一模一样——先是过度乐观的宣称,然后聪明人用 AI 辅助自己,然后 AI 承担更多工作,然后小发现,然后……”

夜雨聆风

夜雨聆风